Paralelismo Inteligente en Python: Acelerando Tareas de IA con `concurrent.futures`

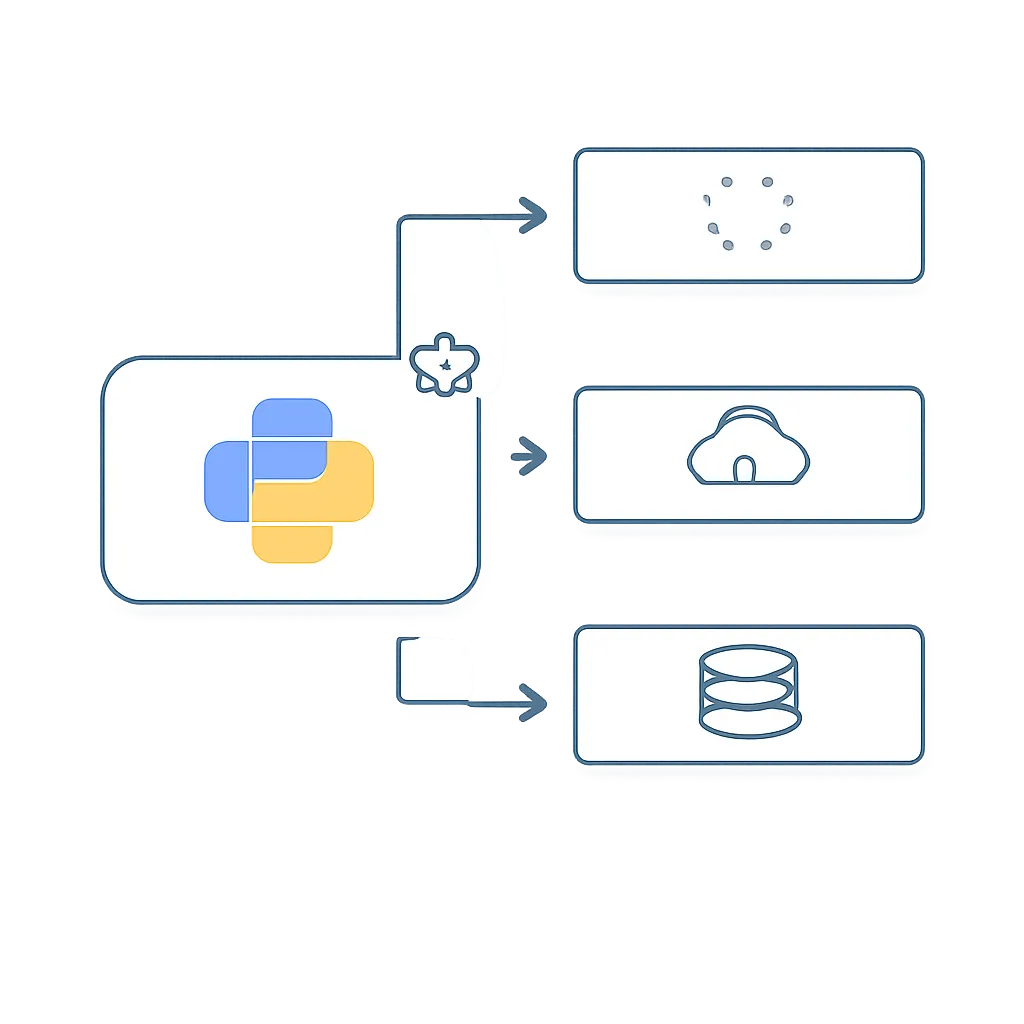

Como desarrollador de Python en el ecosistema de IA, te enfrentarás constantemente a tareas que dependen de recursos externos: llamar a una API de un modelo de lenguaje, descargar conjuntos de datos, consultar una base de datos vectorial o procesar múltiples archivos. Realizar estas operaciones de forma secuencial, una tras otra, es un cuello de botella que puede ralentizar tus aplicaciones drásticamente. Aquí es donde entra en juego la concurrencia.

Este artículo es una guía práctica para que domines concurrent.futures, un módulo de la librería estándar de Python que ofrece una interfaz de alto nivel y fácil de usar para ejecutar tareas de forma asíncrona. Aprenderás a transformar scripts lentos y bloqueantes en código eficiente y rápido, una habilidad crucial para construir aplicaciones de IA robustas y escalables.

Contexto del Problema: El Lento Mundo Secuencial

Imagina que necesitas enriquecer una lista de 100 productos con datos de una API externa. Tu función enriquecer_producto(id_producto) tarda aproximadamente 1 segundo en completarse debido a la latencia de la red.

Si lo haces de forma secuencial:

import time

def enriquecer_producto(id_producto):

print(f"Empezando a enriquecer el producto {id_producto}...")

time.sleep(1) # Simula una llamada a una API externa

print(f"Producto {id_producto} enriquecido.")

return {"id": id_producto, "data": "datos enriquecidos"}

start_time = time.time()

productos = [1, 2, 3, 4, 5]

for producto_id in productos:

enriquecer_producto(producto_id)

end_time = time.time()

print(f"\nTiempo total de ejecución: {end_time - start_time:.2f} segundos.")

# Salida esperada: ~5 segundos

El script tardará unos 5 segundos para 5 productos. Para 100 productos, tardaría 100 segundos. El problema es que durante ese segundo de time.sleep(1), nuestro programa no está haciendo nada útil. La CPU está prácticamente inactiva, esperando una respuesta de la red. Esto se conoce como una tarea "I/O-bound" (limitada por entrada/salida).

Conceptos Clave

Antes de saltar al código, aclaremos tres conceptos fundamentales que a menudo se confunden.

- Concurrencia vs. Paralelismo: La concurrencia es la capacidad de gestionar múltiples tareas a la vez, cambiando el foco entre ellas. Imagina a un chef preparando varios platos: corta verduras para uno, luego vigila la salsa de otro. El paralelismo es la capacidad de ejecutar múltiples tareas simultáneamente. Imagina a varios chefs trabajando cada uno en un plato al mismo tiempo.

concurrent.futuresnos ayuda a lograr concurrencia fácilmente. - Tareas I/O-Bound vs. CPU-Bound: Una tarea es I/O-bound si su velocidad está limitada por la espera de una operación de entrada/salida (leer un archivo, hacer una petición de red, consultar una base de datos). Una tarea es CPU-bound si su velocidad está limitada por la capacidad del procesador (cálculos matemáticos complejos, procesamiento de imágenes, entrenamiento de un modelo pequeño). La estrategia de concurrencia cambia según el tipo de tarea.

- El Global Interpreter Lock (GIL): En CPython (la implementación más común de Python), el GIL es un mutex que protege el acceso a los objetos de Python, impidiendo que múltiples hilos nativos ejecuten bytecodes de Python al mismo tiempo dentro de un mismo proceso. Por esto, el multihilo (threading) en Python no logra un verdadero paralelismo para tareas CPU-bound, pero es perfecto para tareas I/O-bound, ya que un hilo puede liberar el GIL mientras espera la respuesta de la red, permitiendo que otro hilo se ejecute.

Implementación Paso a Paso con `ThreadPoolExecutor`

Para nuestras tareas I/O-bound, usaremos ThreadPoolExecutor. Este crea un "pool" de hilos de trabajo y distribuye las tareas entre ellos. Es la herramienta ideal para el problema que planteamos.

1. El Enfoque `executor.submit()`

El método submit() planifica la ejecución de una función y devuelve inmediatamente un objeto Future. Un Future es una promesa; representa un resultado que estará disponible en el futuro. Podemos consultar este objeto para ver si la tarea ha terminado o para obtener su resultado (bloqueándose hasta que esté disponible).

import time

import concurrent.futures

def enriquecer_producto(id_producto):

print(f"Empezando a enriquecer el producto {id_producto}...")

time.sleep(1)

print(f"Producto {id_producto} enriquecido.")

return {"id": id_producto, "data": "datos enriquecidos"}

start_time = time.time()

productos = [1, 2, 3, 4, 5]

with concurrent.futures.ThreadPoolExecutor(max_workers=5) as executor:

# Creamos un futuro para cada tarea

futuros = [executor.submit(enriquecer_producto, pid) for pid in productos]

# Esperamos a que cada futuro se complete a medida que termina

for futuro in concurrent.futures.as_completed(futuros):

resultado = futuro.result() # Obtiene el resultado (o la excepción si la hubo)

print(f"Recibido resultado: {resultado}")

end_time = time.time()

print(f"\nTiempo total de ejecución: {end_time - start_time:.2f} segundos.")

# Salida esperada: ~1 segundo

¡El tiempo de ejecución se ha reducido a aproximadamente 1 segundo! ¿Por qué? Porque las 5 tareas se ejecutaron concurrentemente, cada una en su propio hilo, esperando la red "a la vez". El tiempo total es ahora el de la tarea más larga, no la suma de todas.

2. El Enfoque `executor.map()`

Si solo necesitas aplicar la misma función a cada elemento de una lista y no te importa el orden en que se procesan los resultados, executor.map() es aún más sencillo. Es similar a la función map() nativa de Python, pero ejecuta las llamadas en hilos separados.

import time

import concurrent.futures

def enriquecer_producto(id_producto):

# Se omite la impresión para una salida más limpia

time.sleep(1)

return {"id": id_producto, "data": "datos enriquecidos"}

start_time = time.time()

productos = [1, 2, 3, 4, 5]

with concurrent.futures.ThreadPoolExecutor(max_workers=5) as executor:

# map devuelve un iterador que produce resultados a medida que se completan

resultados = executor.map(enriquecer_producto, productos)

for resultado in resultados:

print(f"Recibido resultado: {resultado}")

end_time = time.time()

print(f"\nTiempo total de ejecución: {end_time - start_time:.2f} segundos.")

# Salida esperada: ~1 segundo

El código es más limpio y conciso. map se encarga de enviar las tareas y recoger los resultados por nosotros.

Mini Proyecto: Analizador Concurrente de APIs Públicas

Vamos a aplicar lo aprendido en un proyecto práctico. Usaremos la API de Public APIs para obtener una lista de APIs y luego, concurrentemente, haremos una petición a la URL de cada una para verificar su estado y obtener sus cabeceras HTTP.

Dependencias: Necesitarás la librería requests. Si no la tienes, instálala:

pip install requests

El código:

import requests

import time

import concurrent.futures

# URL de la API que lista otras APIs

API_LIST_URL = "https://api.publicapis.org/entries"

def get_api_list(limit=15):

"""Obtiene una lista de APIs de la API pública."""

try:

response = requests.get(API_LIST_URL)

response.raise_for_status() # Lanza una excepción para códigos de error HTTP

entries = response.json()['entries']

return [entry['Link'] for entry in entries[:limit]]

except requests.RequestException as e:

print(f"Error al obtener la lista de APIs: {e}")

return []

def check_api_status(url):

"""Realiza una petición HEAD a una URL para verificar su estado."""

try:

response = requests.head(url, timeout=5) # timeout de 5 segundos

return url, response.status_code, response.headers.get('Server', 'N/A')

except requests.RequestException as e:

return url, 'ERROR', str(type(e).__name__)

# --- Ejecución Secuencial ---

def run_sequentially(urls):

print("--- Ejecutando de forma secuencial ---")

start_time = time.time()

for url in urls:

result = check_api_status(url)

print(f"{result[0]} - Status: {result[1]}")

end_time = time.time()

print(f"\nTiempo secuencial: {end_time - start_time:.2f} segundos\n")

# --- Ejecución Concurrente ---

def run_concurrently(urls):

print("--- Ejecutando de forma concurrente ---")

start_time = time.time()

with concurrent.futures.ThreadPoolExecutor(max_workers=10) as executor:

results = executor.map(check_api_status, urls)

for result in results:

print(f"{result[0]} - Status: {result[1]}")

end_time = time.time()

print(f"\nTiempo concurrente: {end_time - start_time:.2f} segundos")

# --- Snippet de Ejecución ---

if __name__ == "__main__":

api_urls = get_api_list(limit=20)

if api_urls:

run_sequentially(api_urls)

run_concurrently(api_urls)

Al ejecutar este script, verás una diferencia de rendimiento abismal. La versión secuencial tardará la suma de todas las peticiones de red (potencialmente 10-20 segundos o más), mientras que la versión concurrente tardará solo el tiempo de la petición más lenta (probablemente 1-3 segundos).

Errores Comunes y Depuración

- Manejo de Excepciones: ¿Qué pasa si una llamada a la API falla? En el enfoque con

executor.map, si una función lanza una excepción, esa excepción no se levantará hasta que intentes acceder a su resultado en el iterador. Conexecutor.submit, la excepción se almacena en el futuro y se levanta cuando llamas afuturo.result(). Es crucial envolver la lógica dentro de tu función de trabajo en un bloquetry...exceptpara manejar errores de forma granular, como hicimos encheck_api_status. - Elegir `max_workers` adecuado: Poner un número muy alto de workers (ej.

max_workers=1000) no siempre es mejor. Cada hilo consume memoria y puede sobrecargar el sistema o la API a la que estás llamando (pudiendo resultar en un bloqueo por rate limiting). Un buen punto de partida es entre 2 y 5 veces el número de núcleos de tu CPU para tareas I/O-bound, pero el valor óptimo depende de la naturaleza de la tarea y debe ajustarse experimentalmente. Si no se especifica, Python elige un valor por defecto razonable. - Cuidado con el Estado Compartido: La belleza de

concurrent.futureses que fomenta un estilo de programación donde las tareas son independientes. Si tus hilos necesitan modificar una estructura de datos compartida (como una lista o un diccionario), debes usar mecanismos de bloqueo (threading.Lock) para evitar condiciones de carrera (race conditions), donde los hilos interfieren entre sí. Sin embargo, un mejor diseño es que cada tarea devuelva un resultado y el hilo principal se encargue de agregarlos.

Aprendizaje Futuro / Próximos Pasos

Dominar concurrent.futures con ThreadPoolExecutor es un gran paso para acelerar tus aplicaciones de IA. Una vez que te sientas cómodo, aquí tienes los siguientes caminos a explorar:

- `ProcessPoolExecutor` para Tareas CPU-Bound: Si tu cuello de botella es el procesador (ej. preprocesar grandes volúmenes de texto, realizar cálculos numéricos pesados), necesitas verdadero paralelismo.

ProcessPoolExecutorutiliza procesos en lugar de hilos, sorteando el GIL y utilizando todos los núcleos de tu CPU. La interfaz es idéntica, por lo que cambiar de uno a otro es trivial:concurrent.futures.ProcessPoolExecutor(). - AsyncIO para Concurrencia de Alto Rendimiento: Para aplicaciones que manejan miles de conexiones de red simultáneas (como un servidor web con FastAPI),

asyncioes el siguiente nivel. Utiliza un bucle de eventos y un solo hilo para gestionar la concurrencia de forma aún más eficiente en términos de memoria. Su curva de aprendizaje es más pronunciada (requiere el uso deasync/await), pero es el estándar para aplicaciones I/O de muy alta concurrencia. - Colas de Tareas Distribuidas como Celery: Cuando tus tareas son muy largas, necesitan reintentos, o deben ejecutarse en máquinas diferentes,

concurrent.futuresse queda corto. Herramientas como Celery, combinadas con un broker de mensajes como RabbitMQ o Redis, te permiten construir sistemas distribuidos y robustos para procesar tareas en segundo plano a gran escala.

Has aprendido a identificar cuellos de botella I/O-bound y a solucionarlos de manera elegante y eficiente con una herramienta de la librería estándar de Python. Integrar esta técnica en tus proyectos de IA te permitirá construir aplicaciones más rápidas, responsivas y profesionales.