Claude Code vs Codex CLI: Guia Practica para Elegir Tu Coding Agent en 2026

El 5 de febrero de 2026, a las 10:00 AM hora del Pacifico, Anthropic lanzo Claude Opus 4.6. Veinte minutos despues, OpenAI respondio con GPT-5.3 Codex. Yo estaba en medio de un refactor de un servicio de autenticacion cuando mi feed de Reddit exploto. Cerre la laptop, respire, y pense: "Bien, ahora tengo que probar ambos antes de que las opiniones de Twitter se conviertan en mi decision tecnica".

Llevo cuatro semanas usando ambos modelos en proyectos reales -- no en benchmarks sinteticos, no en demos de Twitter. Este articulo es el resultado de esa experiencia: una guia practica para que sepas cuando usar cada uno, cuando combinarlos, y cuando ninguno de los dos es la respuesta correcta.

El Problema Real: No es "Cual es Mejor", sino "Cual Usar Cuando"

La pregunta que veo en todos los foros es: "¿Claude o Codex?". Es la pregunta equivocada. Es como preguntar "¿martillo o destornillador?" -- depende de si estas clavando o atornillando.

Ambos modelos han convergido en calidad general. La diferencia real esta en sus filosofias de diseno y en los flujos de trabajo que optimizan. Entender esto te ahorra horas de frustracion y cientos de dolares en tokens desperdiciados.

Conceptos Clave Antes de Empezar

¿Que es un Coding Agent?

Un coding agent es un modelo de IA que no solo genera codigo, sino que puede ejecutar comandos, leer archivos, iterar sobre errores y completar tareas de desarrollo de forma semi-autonoma. Va mas alla del autocompletado: es delegacion de tareas con supervision.

¿Que es Claude Code?

Claude Code es la interfaz CLI de Anthropic que conecta con los modelos Claude (actualmente Opus 4.6) para desarrollo asistido directamente desde tu terminal. Enfasis en developer-in-the-loop: tu revisas, apruebas y guias.

¿Que es Codex CLI?

Codex CLI es la herramienta equivalente de OpenAI, potenciada por GPT-5.3 Codex. Su filosofia es mas "trust and let it run": delegas una tarea y el agente trabaja de forma autonoma, incluyendo ejecucion en la nube con sandboxing.

Benchmarks: Lo que Dicen los Numeros (y lo que No)

Antes de entrar en la practica, veamos los datos duros. Pero con una advertencia: los benchmarks miden capacidad del modelo, no productividad del desarrollador. Un modelo que saca 80% en SWE-Bench pero tarda 3x mas en tu flujo real puede ser peor eleccion que uno con 65% que se integra sin friccion.

| Benchmark | Claude Opus 4.6 | GPT-5.3 Codex | ¿Que mide? |

|---|---|---|---|

| SWE-Bench Verified | 80.8% | 56.8% | Resolucion de bugs reales en repos de GitHub |

| Terminal-Bench 2.0 | 65.4% | 77.3% | Ejecucion agentica: scripts, builds, navegacion |

| OSWorld | 72.7% | 64.7% (record previo) | Control de aplicaciones de escritorio |

| GPQA Diamond | 77.3% | -- | Razonamiento academico y profesional |

Lo interesante: Opus 4.6 domina en correccion de bugs reales (SWE-Bench), mientras Codex lidera en tareas agenticas que requieren encadenar multiples comandos de terminal (Terminal-Bench). Esto no es casualidad -- refleja exactamente sus filosofias de diseno.

Implementacion Paso a Paso: Configurando Ambos Agentes

1. Instalar Claude Code

# Instalar Claude Code via npm

npm install -g @anthropic-ai/claude-code

# Verificar instalacion

claude --version

# Autenticarse (necesitas cuenta Anthropic con API key o suscripcion)

claude auth login

# Iniciar sesion en tu proyecto

cd mi-proyecto

claude

Resultado esperado: Claude Code abre una sesion interactiva en tu terminal, lee el contexto de tu proyecto y esta listo para recibir instrucciones.

2. Instalar Codex CLI

# Instalar Codex CLI

npm install -g @openai/codex

# Configurar API key

export OPENAI_API_KEY=tu-api-key-aqui

# Iniciar en tu proyecto

cd mi-proyecto

codex

Resultado esperado: Codex CLI se conecta y te muestra un prompt interactivo. A diferencia de Claude Code, Codex ofrece modos de autonomia configurables desde el inicio.

3. Configurar el Contexto del Proyecto

Ambas herramientas se benefician enormemente de un archivo de contexto. Para Claude Code, creas un CLAUDE.md en la raiz del proyecto:

# CLAUDE.md

## Stack

- Python 3.12, FastAPI, PostgreSQL

- Tests: pytest con coverage > 80%

## Convenciones

- Imports: stdlib > third-party > local

- Type hints obligatorios

- Commits en ingles, Conventional Commits

## Errores Conocidos

- El modulo auth usa bcrypt legacy, no migrar aun

Para Codex, el equivalente es un archivo AGENTS.md o instrucciones en el system prompt. La ventaja de Claude Code aqui es clara: el archivo CLAUDE.md se versiona con Git, todo el equipo lo mantiene, y el agente lo lee automaticamente.

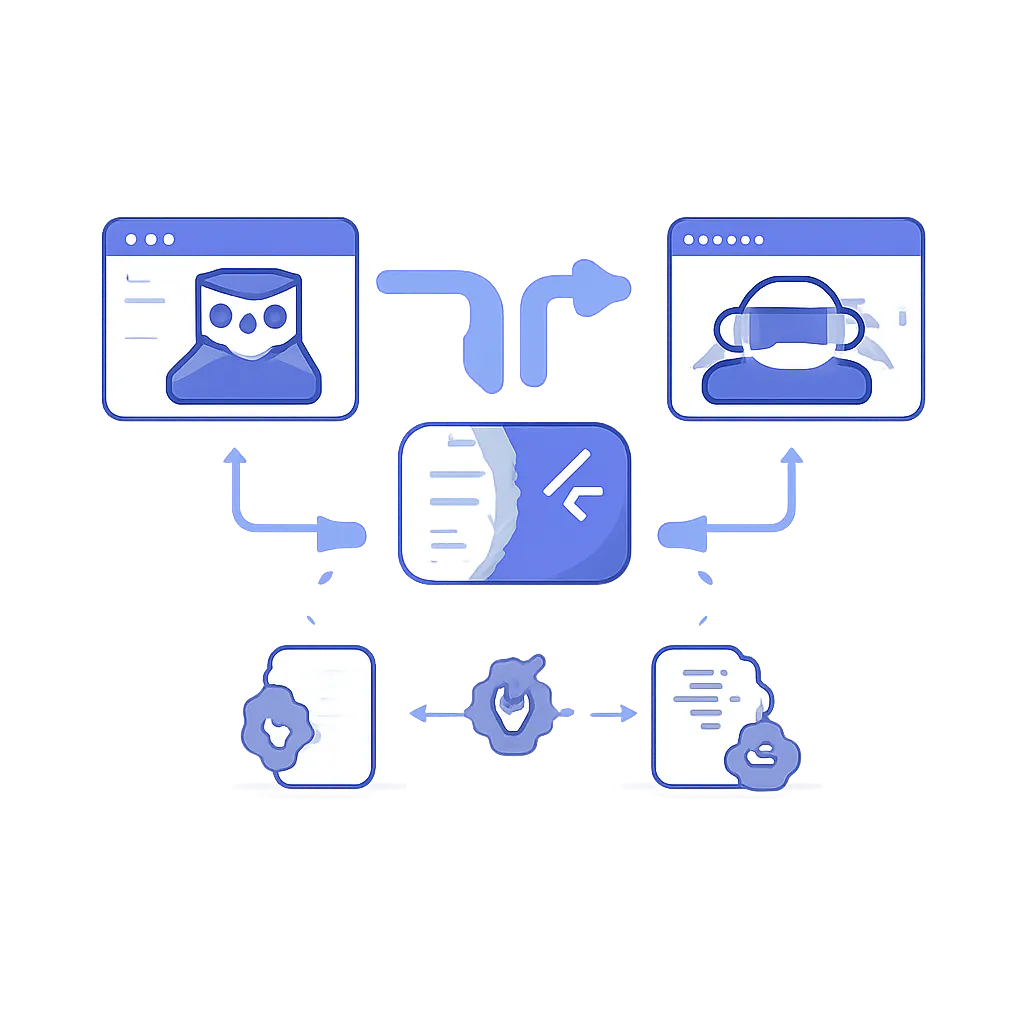

El Workflow Sandwich: Combinando Ambos Agentes

Este es el patron que mejor me ha funcionado en produccion. Lo llaman "sandwich" en la comunidad porque el trabajo queda entre dos capas de calidad:

- Scaffolding con Opus 4.6: Usas Claude Code para planificar la arquitectura, definir interfaces y generar la estructura base. Opus es superior en razonamiento profundo y planificacion.

- Iteracion rapida con Codex: Para implementar los detalles, escribir tests unitarios repetitivos, y completar boilerplate, Codex es ~25% mas rapido y consume menos tokens.

- Auditoria con Opus 4.6: Vuelves a Claude Code para revision de codigo, deteccion de vulnerabilidades y refactoring final. Opus 4.6 descubrio mas de 500 zero-days en codigo open source durante pruebas de Anthropic.

En la practica, esto se ve asi:

# Paso 1: Planificacion con Claude Code

claude "Necesito un servicio de notificaciones push. \

Dime la arquitectura, interfaces y dependencias \

antes de escribir codigo."

# Paso 2: Implementacion rapida con Codex

codex "Implementa el NotificationService siguiendo \

esta interfaz: [pegar output del paso 1]. \

Incluye tests unitarios con pytest."

# Paso 3: Auditoria con Claude Code

claude "Revisa este PR. Busca vulnerabilidades de \

seguridad, race conditions, y problemas de \

rendimiento. Se critico."

¿Cuando Usar Cada Uno? Casos Reales

Usa Claude Code cuando:

- Refactors grandes: Un cambio que toca 15+ archivos necesita el razonamiento profundo y la ventana de contexto de 1M tokens de Opus 4.6.

- Debugging complejo: En mi proyecto de microservicios, Claude Code rastreo un bug de serializacion que cruzaba 4 servicios. Codex se perdio en el tercer archivo.

- Revision de seguridad: Opus 4.6 tiene capacidad demostrada para detectar vulnerabilidades zero-day. Para auditorias pre-deploy, no hay competencia.

- Proyectos nuevos desde cero: La planificacion y arquitectura inicial es donde Opus brilla mas.

Usa Codex CLI cuando:

- Tareas bien definidas y repetitivas: "Agrega validacion de email a estos 8 endpoints". Codex es mas rapido y barato para trabajo mecanico.

- Problemas algoritmicos puntuales: Para funciones aisladas tipo HumanEval, Codex es 2-3x mas rapido.

- Trabajo asincrono: Codex puede correr en la nube mientras tu haces otra cosa. Claude Code necesita tu terminal activa.

- Presupuesto limitado: Token por token, Codex es significativamente mas barato para alto volumen.

En Produccion: Lo que Cambia del Tutorial a la Realidad

Esta seccion existe porque en cada tutorial de coding agents omiten los mismos tres problemas:

Costos Reales

En mi experiencia con un proyecto de tamano medio (FastAPI, ~50 archivos, ~8000 lineas):

- Claude Code con Max plan ($100/mes): Suficiente para ~4-5 horas diarias de uso intenso. Usuarios reportan quedarse sin tokens en 30 minutos durante refactors masivos. Solucion: planifica bien antes de ejecutar.

- Codex con Pro ($200/mes): Rara vez se alcanzan los limites. Mejor para uso continuo a lo largo del dia.

- Por API: Opus 4.6 es 17% mas barato en uso estandar, pero Codex es mas economico en tokens de salida. Para un refactor de 6M tokens, Claude Code costo ~$45 vs ~$28 de Codex en un benchmark reciente.

Rate Limits y Throttling

A febrero de 2026, ambos servicios tienen rate limits que afectan flujos de trabajo en equipo. Si 3 desarrolladores usan Claude Code simultaneamente contra el mismo repo, esperan colas. La solucion practica: turnos de uso o planes Enterprise con limites elevados.

Seguridad en Equipos

Ambas herramientas ejecutan comandos en tu terminal. Tratalo como darias acceso SSH a un junior: restringe permisos, usa sandboxing, y revisa los diffs antes de hacer commit. Claude Code tiene permisos configurables en .claude/settings.json. Codex ofrece ejecucion sandboxed en la nube.

Lo que Ningun Agente Reemplaza

Ni Claude ni Codex eliminan la necesidad de entender tu codigo. Los coding agents comprimen tiempos, no eliminan competencias. Arquitectura, criterio de testing, y pensamiento de seguridad siguen siendo 100% tu responsabilidad.

Errores Comunes y Depuracion

Error: Claude Code pierde contexto en sesiones largas

Causa: La compactacion de contexto descarta detalles numericos y logica condicional.

Solucion: Usa /compact con instrucciones de foco. Divide tareas grandes en sesiones cortas. Escribe estado a disco (CLAUDE.md, SCRATCHPAD.md) en vez de confiar en la memoria de conversacion.

Error: Codex genera codigo que compila pero falla en integracion

Causa: Codex optimiza por velocidad y puede saltarse dependencias de contexto entre archivos.

Solucion: Siempre incluye archivos de referencia en tu prompt. Usa el modo "full-auto" solo para tareas aisladas, no para cambios cross-cutting.

Error: Ambos agentes generan imports inexistentes o versiones incorrectas

Causa: Los modelos tienen conocimiento de paquetes hasta su fecha de corte de entrenamiento.

Solucion: Incluye tu requirements.txt o package.json en el contexto. Especifica versiones exactas en tu archivo de configuracion del agente.

Error: Costos inesperadamente altos en una sola sesion

Causa: Prompts vagos generan loops de iteracion donde el agente intenta multiples enfoques.

Solucion: Se especifico. "Implementa X usando Y patron con Z dependencia" consume 3-5x menos tokens que "haz que funcione".

Mi Recomendacion: El Stack de Coding Agents para 2026

Despues de semanas probando combinaciones, este es el stack que uso a diario:

- Claude Code como agente principal: Para planificacion, arquitectura, debugging, y revision de codigo. Es mi "senior engineer" virtual.

- Codex CLI para ejecucion rapida: Para tareas bien definidas, tests repetitivos, y trabajo asincrono. Es mi "implementador veloz".

- CLAUDE.md como fuente de verdad compartida: Versionado en Git, mantenido por el equipo. Contiene convenciones, errores conocidos, y decisiones arquitectonicas.

- Revision humana como paso obligatorio: Ningun merge sin diff review. Punto.

La frase que mejor resume el estado actual: "Usa Codex para tus keystrokes y Claude Code para tus commits". No es sobre elegir uno -- es sobre saber cuando cada herramienta aporta mas valor.

Preguntas Frecuentes

¿Puedo usar ambos en el mismo proyecto?

Si. No hay conflicto tecnico. Ambos operan sobre tu sistema de archivos local. El unico cuidado: no ejecutes ambos simultaneamente sobre los mismos archivos para evitar conflictos de escritura.

¿Cual es mejor para aprender a programar?

Claude Code. Su filosofia developer-in-the-loop te obliga a revisar y entender cada cambio. Codex puede hacer demasiado sin que entiendas por que.

¿Los benchmarks de febrero 2026 van a cambiar pronto?

Muy probablemente. Google tiene Gemini 3 en beta, y ambos modelos reciben actualizaciones menores frecuentes. No tomes decisiones de largo plazo basadas solo en benchmarks actuales -- evalua el flujo de trabajo completo.

¿Que pasa con Cursor, Windsurf, y otros editores con IA?

Son complementarios, no competidores directos. Cursor y Windsurf integran multiples modelos (incluyendo Opus y Codex) en una experiencia de editor. Claude Code y Codex CLI son para quienes prefieren la terminal. Elige segun tu flujo de trabajo habitual.

¿Que Sigue?

La guerra de coding agents apenas empieza. Claude Code acaba de lanzar Agent Teams (multiples instancias colaborando autonomamente) y Codex tiene ejecucion en la nube con sandboxing nativo. Ambas capacidades cambian fundamentalmente lo que un solo desarrollador puede lograr.

Mi siguiente articulo explorara Agent Teams en profundidad -- como orquestar 3-5 agentes Claude para atacar un proyecto complejo en paralelo. Es el futuro del desarrollo asistido por IA, y ya esta disponible en research preview.

¿Ya probaste alguno de estos modelos? ¿Cual ha sido tu experiencia real, mas alla de los benchmarks? Me interesa especialmente saber si alguien mas esta usando el workflow sandwich en produccion.