FastAPI y Tareas en Segundo Plano: Procesamiento Asíncrono para APIs de IA

En el mundo de la Inteligencia Artificial, es común encontrarse con operaciones que requieren una cantidad significativa de tiempo para completarse. Ya sea el procesamiento de un modelo de lenguaje grande (LLM), el análisis de una imagen de alta resolución, o la ejecución de un algoritmo de machine learning complejo, estas tareas pueden bloquear el hilo principal de tu aplicación, haciendo que tu API parezca lenta o no responda. Para los desarrolladores que construyen APIs de IA con FastAPI, esto representa un desafío crucial: ¿cómo mantener la API responsiva mientras se ejecutan procesos intensivos en segundo plano?

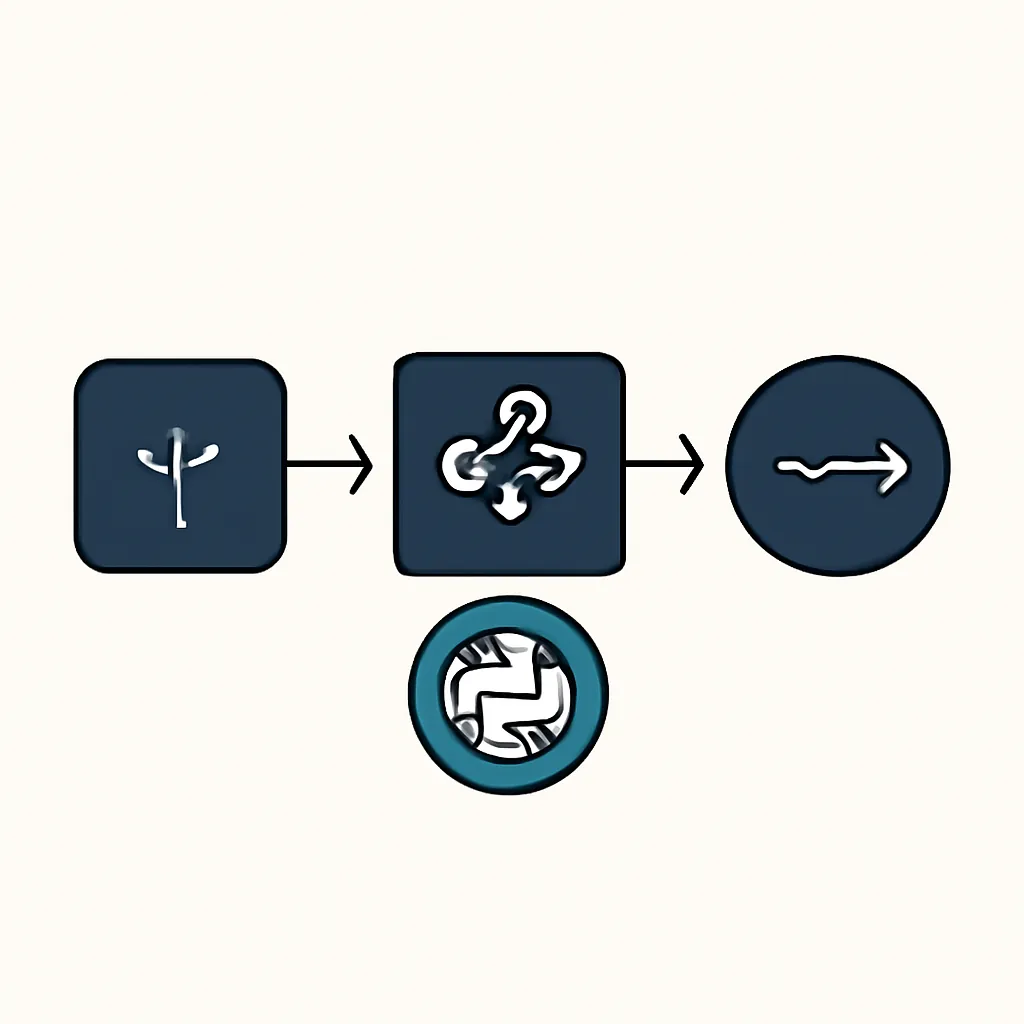

Este artículo te guiará a través del uso de BackgroundTasks en FastAPI, una herramienta poderosa para ejecutar código de forma asíncrona sin bloquear la respuesta HTTP. Aprenderás a transformar tus APIs de IA para que puedan manejar cargas de trabajo pesadas de manera eficiente, mejorando la experiencia del usuario y la escalabilidad de tus soluciones. [1, 5, 6, 7, 10, 12, 17]

Contexto del Problema: APIs de IA Bloqueantes

Imagina que estás construyendo una API que toma una imagen, la procesa con un modelo de visión por computadora y devuelve un resultado. Si el procesamiento de la imagen tarda 10 segundos, el cliente que hizo la solicitud tendrá que esperar esos 10 segundos antes de recibir cualquier respuesta. Durante ese tiempo, el servidor está ocupado con esa solicitud y podría tener dificultades para atender otras, especialmente si el número de solicitudes concurrentes aumenta. [2, 5, 9]

Este comportamiento bloqueante es inaceptable para muchas aplicaciones modernas. Los usuarios esperan respuestas rápidas, y las APIs deben ser capaces de manejar múltiples solicitudes simultáneamente sin degradación del rendimiento. Aquí es donde entran en juego las tareas en segundo plano. [2, 5, 9]

Conceptos Clave: Asincronía y Tareas en Segundo Plano

Asincronía en Python y FastAPI

Python, a través de asyncio, permite escribir código concurrente que no bloquea el hilo principal. FastAPI está construido sobre Starlette y Uvicorn, que son frameworks asíncronos. Esto significa que FastAPI puede manejar múltiples conexiones de red simultáneamente, cambiando entre tareas mientras esperan operaciones de E/S (entrada/salida) como leer de una base de datos o hacer una solicitud HTTP externa. [16, 25, 30]

Sin embargo, una operación de CPU intensiva (como un cálculo de IA) ejecutada directamente en una función async def de FastAPI seguirá bloqueando el bucle de eventos. Para evitar esto, FastAPI ejecuta las funciones def normales (síncronas) en un thread pool separado, lo que permite que el bucle de eventos principal siga manejando otras solicitudes. Pero, ¿qué pasa si queremos que una tarea se ejecute después de que la respuesta HTTP ya ha sido enviada? [23, 27]

¿Qué son las BackgroundTasks?

BackgroundTasks en FastAPI es una utilidad que te permite programar funciones para que se ejecuten en segundo plano después de que la respuesta HTTP haya sido enviada al cliente. Esto es ideal para tareas que no necesitan que el cliente espere, como: [1, 3, 5, 7, 13, 15, 22]

- Enviar correos electrónicos de confirmación. [1, 5, 7, 13, 17]

- Generar informes complejos. [5, 7]

- Procesar datos con modelos de IA que no requieren una respuesta inmediata. [1, 5, 7, 17]

- Actualizar cachés o bases de datos después de una operación. [15, 20]

Es importante entender que BackgroundTasks se ejecuta en el mismo proceso de la aplicación FastAPI. No es un sistema de colas de tareas distribuido como Celery o RQ. Es más adecuado para tareas de corta a media duración que no requieren persistencia o reintentos en caso de fallo del servidor. [1, 2, 3, 5, 13, 15, 23, 27]

Implementación Paso a Paso: De Bloqueante a Asíncrono

Comencemos con un ejemplo simple de una API de IA bloqueante y luego la refactorizaremos para usar BackgroundTasks.

Paso 1: Configuración del Entorno

Primero, asegúrate de tener FastAPI y Uvicorn instalados:

pip install fastapi uvicornPaso 2: API de IA Bloqueante (El Problema)

Consideremos una API que simula un procesamiento de texto con IA que tarda 5 segundos.

# main_bloqueante.py

import time

from fastapi import FastAPI

app = FastAPI()

def simulate_ai_processing(text: str):

"""Simula un procesamiento de IA que tarda 5 segundos."""

print(f"Iniciando procesamiento para: '{text}'...")

time.sleep(5) # Simula una tarea intensiva de CPU/E/S

result = f"Texto procesado: '{text.upper()}'"

print(f"Procesamiento completado para: '{text}'")

return result

@app.post("/process_text_blocking/")

async def process_text_blocking(text: str):

print("Recibida solicitud de procesamiento bloqueante.")

processed_result = simulate_ai_processing(text)

return {"message": "Procesamiento completado (bloqueante)", "result": processed_result}

# Para ejecutar: uvicorn main_bloqueante:app --reload --port 8000

Si ejecutas esta API (uvicorn main_bloqueante:app --reload --port 8000) y haces una solicitud POST a /process_text_blocking/, notarás que la respuesta tarda 5 segundos. Si intentas hacer otra solicitud mientras la primera está en curso, la segunda también esperará. [2]

Paso 3: Introduciendo BackgroundTasks

Ahora, refactoricemos la API para usar BackgroundTasks. Necesitamos importar BackgroundTasks de FastAPI y añadirla como un parámetro a nuestra función de ruta. [1, 2, 3, 6, 7, 22]

# main_background.py

import time

from fastapi import FastAPI, BackgroundTasks

from pydantic import BaseModel

app = FastAPI()

# Para simular un almacenamiento de resultados

# En una aplicación real, usarías una base de datos o un sistema de colas

task_results = {}

class TextProcessRequest(BaseModel):

text: str

task_id: str # Para identificar la tarea

def long_running_ai_task(task_id: str, text: str):

"""Simula un procesamiento de IA que tarda 5 segundos y guarda el resultado."""

print(f"[{task_id}] Iniciando procesamiento en segundo plano para: '{text}'...")

time.sleep(5) # Simula una tarea intensiva de CPU/E/S

result = f"Texto procesado asíncronamente: '{text.upper()}'"

task_results[task_id] = {"status": "completed", "result": result}

print(f"[{task_id}] Procesamiento en segundo plano completado.")

@app.post("/process_text_async/")

async def process_text_async(request: TextProcessRequest, background_tasks: BackgroundTasks):

print(f"Recibida solicitud de procesamiento asíncrono para ID: {request.task_id}")

# Añadir la tarea a las tareas en segundo plano

background_tasks.add_task(long_running_ai_task, request.task_id, request.text)

task_results[request.task_id] = {"status": "pending", "result": None}

return {"message": "Procesamiento iniciado en segundo plano", "task_id": request.task_id, "status": "pending"}

@app.get("/task_status/{task_id}")

async def get_task_status(task_id: str):

status = task_results.get(task_id, {"status": "not_found", "result": None})

return status

# Para ejecutar: uvicorn main_background:app --reload --port 8000

En este ejemplo: [1, 2, 3, 6, 7, 22]

- Definimos una función

long_running_ai_taskque contiene la lógica de procesamiento de IA. Esta función es una función síncrona normal. [1] - En la ruta

/process_text_async/, inyectamosBackgroundTaskscomo un parámetro. [1] - Usamos

background_tasks.add_task()para programar nuestra función de IA. Le pasamos la función y sus argumentos. [1, 2, 6, 7, 22] - La API responde inmediatamente con un mensaje de confirmación y un

task_id. El procesamiento de IA se ejecuta en segundo plano. [2, 13, 15, 28] - Añadimos un endpoint

/task_status/{task_id}para que el cliente pueda consultar el estado de su tarea. Esto es un patrón común para tareas asíncronas. [9, 14, 19]

Ahora, si ejecutas esta API y haces una solicitud POST, recibirás una respuesta casi instantánea. Luego, puedes usar el task_id para consultar el estado de la tarea hasta que se complete. [2, 19]

Mini Proyecto: Procesador de Documentos con IA Asíncrono

Vamos a construir una pequeña aplicación que simule el procesamiento de un documento con IA (por ejemplo, extracción de entidades o resumen) utilizando BackgroundTasks. El usuario subirá un documento (simulado como texto), y la API iniciará el procesamiento en segundo plano, devolviendo un ID de tarea para que el usuario pueda consultar el resultado más tarde. [17, 19]

Estructura del Proyecto

.

├── main.py

├── requirements.txt

requirements.txt

fastapi

uvicorn[standard]

pydanticmain.py

import time

import uuid

from typing import Dict

from fastapi import FastAPI, BackgroundTasks, HTTPException

from pydantic import BaseModel

app = FastAPI(

title="Procesador de Documentos IA Asíncrono",

description="API para procesar documentos con IA en segundo plano."

)

# Almacenamiento en memoria para los resultados de las tareas.

# En producción, esto debería ser una base de datos (Redis, PostgreSQL, etc.)

# para persistencia y escalabilidad.

task_store: Dict[str, Dict] = {}

class DocumentProcessRequest(BaseModel):

content: str # Contenido del documento a procesar

model_name: str = "default_ai_model" # Nombre del modelo de IA a usar

class TaskStatusResponse(BaseModel):

task_id: str

status: str # "pending", "processing", "completed", "failed"

result: Dict | None = None

error: str | None = None

def simulate_ai_document_processing(task_id: str, content: str, model_name: str):

"""

Simula una tarea de procesamiento de documentos con IA.

Esta función se ejecutará en segundo plano.

"""

print(f"[{task_id}] Iniciando procesamiento de documento con modelo '{model_name}'...")

try:

# Simular un tiempo de procesamiento variable

processing_time = len(content) / 100 + 3 # Más largo para documentos más grandes

if processing_time > 10: processing_time = 10 # Limitar a 10 segundos

time.sleep(processing_time)

# Simular un resultado de IA

processed_data = {

"summary": f"Resumen generado por {model_name}: {content[:50]}...",

"keywords": [word for word in content.lower().split() if len(word) > 4][:5],

"entities": [{"text": "FastAPI", "type": "Framework"}, {"text": "IA", "type": "Concepto"}]

}

task_store[task_id].update({

"status": "completed",

"result": processed_data

})

print(f"[{task_id}] Procesamiento de documento completado.")

except Exception as e:

task_store[task_id].update({

"status": "failed",

"error": str(e)

})

print(f"[{task_id}] Procesamiento de documento fallido: {e}")

@app.post("/process_document/", response_model=TaskStatusResponse, status_code=202)

async def process_document(request: DocumentProcessRequest, background_tasks: BackgroundTasks):

"""

Inicia el procesamiento de un documento con IA en segundo plano.

Devuelve un ID de tarea para consultar el estado.

"""

task_id = str(uuid.uuid4())

task_store[task_id] = {

"task_id": task_id,

"status": "pending",

"result": None,

"error": None

}

background_tasks.add_task(

simulate_ai_document_processing,

task_id,

request.content,

request.model_name

)

return TaskStatusResponse(task_id=task_id, status="pending")

@app.get("/document_status/{task_id}", response_model=TaskStatusResponse)

async def get_document_status(task_id: str):

"""

Consulta el estado y el resultado de una tarea de procesamiento de documento.

"""

task_info = task_store.get(task_id)

if not task_info:

raise HTTPException(status_code=404, detail="Task not found")

return TaskStatusResponse(**task_info)

# Para ejecutar: uvicorn main:app --reload --port 8000

Cómo Probarlo

- Guarda el código anterior como

main.pyyrequirements.txt. - Instala las dependencias:

pip install -r requirements.txt - Ejecuta la aplicación:

uvicorn main:app --reload --port 8000 - Abre tu navegador en

http://localhost:8000/docspara acceder a la interfaz de Swagger UI. -

Haz una solicitud POST a

/process_document/con un cuerpo como este:

Recibirás una respuesta casi instantánea con un{ "content": "Este es un documento de prueba para demostrar el procesamiento asíncrono con FastAPI y BackgroundTasks. Contiene información sobre la Inteligencia Artificial y el ecosistema Python.", "model_name": "summarizer_v1" }task_id. [2, 19] -

Copia el

task_idy haz una solicitud GET a/document_status/{task_id}. Inicialmente, verás"status": "pending"o"status": "processing". Después de unos segundos (dependiendo de la longitud del contenido), si vuelves a consultar, verás"status": "completed"y el"result". [9, 14, 19]

Errores Comunes y Depuración

-

Confundir

BackgroundTaskscon un sistema de colas de tareas distribuido:BackgroundTaskses simple y se ejecuta en el mismo proceso de la aplicación. Si tu aplicación se reinicia o se cae, las tareas en segundo plano no persistirán ni se reintentarán. Para tareas críticas, de muy larga duración, o que necesitan ser distribuidas entre múltiples workers, deberías considerar soluciones como Celery, RQ (Redis Queue) o Apache Kafka/RabbitMQ con workers dedicados. [1, 2, 4, 5, 11, 13, 15, 27, 28]# Cuándo NO usar BackgroundTasks: # - Tareas que duran minutos u horas. [13] # - Tareas que deben sobrevivir a reinicios del servidor. [5, 15] # - Tareas que necesitan ser reintentadas automáticamente. [2, 5, 13, 15] # - Tareas que requieren un seguimiento de progreso complejo. [2] -

Bloquear el bucle de eventos con tareas síncronas largas:

Aunque

BackgroundTasksayuda a enviar la respuesta rápidamente, si la función que añades aBackgroundTaskses síncrona y extremadamente larga, aún puede consumir recursos del thread pool de Uvicorn, afectando potencialmente el rendimiento general si hay muchas tareas concurrentes. Para tareas de CPU intensivas muy largas, considera ejecutarlas en un proceso separado o usar un un sistema de colas de tareas distribuido. [2, 8, 14, 15, 18, 23, 27, 31] -

Manejo de estado y concurrencia:

En nuestro ejemplo, usamos un diccionario global

task_store. Esto es aceptable para ejemplos simples, pero en una aplicación real, necesitarías un mecanismo de almacenamiento persistente y concurrente (como una base de datos o Redis) para el estado de las tareas, especialmente si tienes múltiples instancias de tu API. [5, 19, 23, 31]# Problema: task_store es un diccionario en memoria. # Si la aplicación se reinicia, se pierde el estado de las tareas. [5] # Si tienes múltiples instancias de FastAPI (escalado horizontal), # cada instancia tendrá su propia task_store, lo que lleva a inconsistencias. [31] # Solución: Usar una base de datos compartida (Redis, PostgreSQL, MongoDB). [5, 19, 31] -

Errores en tareas en segundo plano:

Los errores dentro de una

BackgroundTasksno se propagarán directamente al cliente que hizo la solicitud inicial, ya que la respuesta ya fue enviada. Es crucial implementar un manejo de errores robusto dentro de la función de la tarea y registrar los errores adecuadamente. En nuestro ejemplo, actualizamos el estado de la tarea a "failed" y guardamos el mensaje de error. [3, 7, 22]

Aprendizaje Futuro

BackgroundTasks es un excelente punto de partida para manejar el procesamiento asíncrono en tus APIs de IA con FastAPI. Sin embargo, a medida que tus aplicaciones crezcan en complejidad y escala, querrás explorar soluciones más robustas: [5, 7, 9, 13]

- Sistemas de Colas de Tareas (Celery, RQ): Para tareas de larga duración, persistencia, reintentos automáticos, programación de tareas y distribución entre múltiples workers. Son esenciales para microservicios de IA complejos. [1, 2, 4, 5, 7, 9, 11, 13, 14, 27, 28]

- WebSockets para Notificaciones en Tiempo Real: En lugar de que el cliente haga polling para el estado de la tarea, puedes usar WebSockets para enviar notificaciones en tiempo real al cliente una vez que la tarea en segundo plano se complete. [9, 19]

-

Bases de Datos para el Estado de Tareas: Reemplaza el diccionario en memoria

task_storecon una base de datos (como PostgreSQL, MongoDB o Redis) para asegurar la persistencia y la consistencia del estado de las tareas a través de reinicios y múltiples instancias de la API. [5, 19, 31] - Docker y Despliegue: Aprender a empaquetar tu aplicación FastAPI con Docker y desplegarla en servicios en la nube como Railway, Render, AWS ECS o Google Cloud Run, te permitirá escalar tus APIs de IA de manera efectiva. [14]

- Monitoring y Observabilidad: Implementar herramientas de logging y monitoreo para tus tareas en segundo plano es crucial para entender su rendimiento y depurar problemas en producción. [3, 7]

Dominar el procesamiento asíncrono es una habilidad fundamental para construir APIs de IA eficientes y escalables. Con BackgroundTasks, tienes una herramienta poderosa para empezar a resolver este desafío hoy mismo. [7, 25]