Guía Práctica para Implementar un Sistema RAG (Retrieval-Augmented Generation) con LangChain y OpenAI

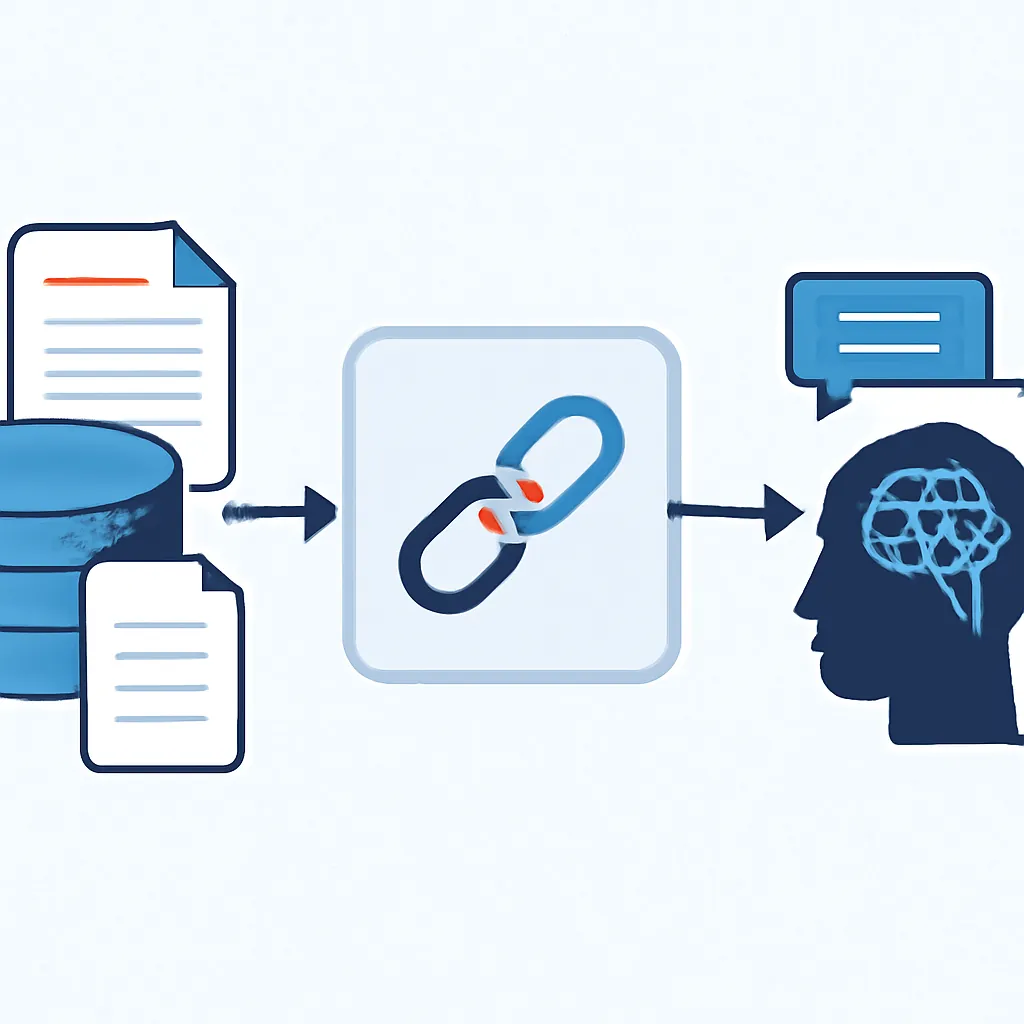

En el campo de la Inteligencia Artificial, los sistemas Retrieval-Augmented Generation (RAG) están revolucionando la forma en la que los modelos de lenguaje generan respuestas más precisas y contextualizadas. Esta técnica combina modelos generativos como los LLMs (Modelos de Lenguaje Grandes) con un sistema de recuperación de información, para enriquecer las respuestas con datos relevantes provenientes de bases de conocimiento o documentos específicos.

En esta guía intermedia, aprenderás a implementar un sistema RAG usando LangChain y la API de OpenAI, construyendo un pipeline que integra recuperación vectorial y generación de texto para ofrecer respuestas mejor fundamentadas.

¿Qué es un Sistema RAG?

Un sistema RAG consta básicamente de dos componentes principales:

- Retriever (Recuperador): Extrae de una base de datos o colección de documentos la información más relevante relacionada con la consulta del usuario.

- Generator (Generador): Un modelo de lenguaje que genera texto usando la información recuperada, aumentando la precisión y contextualidad de la respuesta.

Combinar estos dos modelos permite superar limitaciones de los LLM, que pueden olvidarse de hechos específicos o no tener acceso a datos actualizados.

Requisitos Previos

- Cuenta activa en OpenAI con acceso a la API GPT-4 o GPT-3.5.

- Python 3.8+ instalado.

- Instalación de paquetes:

langchain,faiss-cpuofaiss-gpupara vectorización, yopenai. - Conocimientos básicos de Python y APIs REST.

Instalación de Dependencias

pip install langchain openai faiss-cpuPasos para Implementar un Sistema RAG

1. Preparar el Corpus de Documentos

Para el ejemplo usaremos una lista de documentos cortos, pero esta base puede ser cualquier colección de textos o artículos relevantes.

documents = [

"La inteligencia artificial es un campo de estudio que busca crear sistemas capaces de aprender y tomar decisiones.",

"LangChain es una librería que facilita la integración de modelos de lenguaje con datos externos.",

"FAISS es una biblioteca para indexar y buscar vectores de manera eficiente.",

"OpenAI proporciona modelos de lenguaje avanzados para generación de texto.",

"Los sistemas RAG combinan recuperación de información con generación para mejorar respuestas."

]2. Vectorizar los Documentos

Utilizaremos un modelo de embeddings de OpenAI para convertir los textos en vectores numéricos, almacenándolos en un índice FAISS.

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS

embeddings = OpenAIEmbeddings(openai_api_key="TU_API_KEY")

vectorstore = FAISS.from_texts(documents, embeddings)3. Configurar el Retriever

El retriever permitirá buscar la información más pertinente en el conjunto de documentos vectorizados.

retriever = vectorstore.as_retriever(search_kwargs={"k": 3}) # Buscar las 3 respuestas más relevantes4. Crear el LLM Generator usando la API de OpenAI

from langchain.chat_models import ChatOpenAI

llm = ChatOpenAI(model_name="gpt-4", openai_api_key="TU_API_KEY", temperature=0)5. Construir la Cadena RAG

LangChain facilita la creación del pipeline combinando el Retriever con el modelo generativo:

from langchain.chains import RetrievalQA

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff", # "stuff" concatena textos para la generación

retriever=retriever

)6. Realizar Consultas al Sistema RAG

query = "¿Qué es LangChain y para qué sirve?"

response = qa_chain.run(query)

print(response)La salida será una respuesta generada que toma en cuenta la información recuperada en los documentos relevantes.

Detalles Técnicos y Consideraciones

- Elección de embeddings: Los embeddings de OpenAI son potentes, pero puedes usar modelos locales o específicos para diferentes dominios.

- Índices vectoriales: FAISS es eficiente para búsquedas rápidas, pero hay otras bases vectoriales como Pinecone, Weaviate o Milvus.

- Token Limit: El método

"stuff"concatena texto para el input del modelo, por lo que debes vigilar el límite de tokens del LLM. - Escalabilidad: Para volúmenes grandes de datos, lo ideal es construir cadenas más sofisticadas y dividir consultas en fragmentos.

- Seguridad: Protege las claves API y controla el acceso a los documentos confidenciales.

Conclusión

Los sistemas RAG ofrecen una forma muy potente de mejorar la precisión y contextualidad de los modelos generativos al integrarlos con fuentes de datos externas. En esta guía práctica hemos visto cómo montar un sistema básico usando LangChain y OpenAI, abriendo la puerta a aplicaciones como atención al cliente inteligente, chatbots especializados, generación de contenido con respaldo documental y más.

Te animamos a experimentar con diferentes bases de datos vectoriales, parámetros del modelo y corpora para adaptar el sistema a tus necesidades reales. ¡La convergencia entre recuperación y generación es una de las áreas más emocionantes en la Inteligencia Artificial hoy día!