Guía Práctica para Implementar un Pipeline de Inferencia en TensorFlow Serving con Docker

En esta guía aprenderás a desplegar un modelo de TensorFlow para inferencia utilizando TensorFlow Serving y Docker. Este tutorial está dirigido a desarrolladores y estudiantes con conocimientos básicos en machine learning que desean dar el siguiente paso hacia la producción de modelos, implementando un pipeline robusto, escalable y reproducible.

¿Qué es TensorFlow Serving y por qué usar Docker?

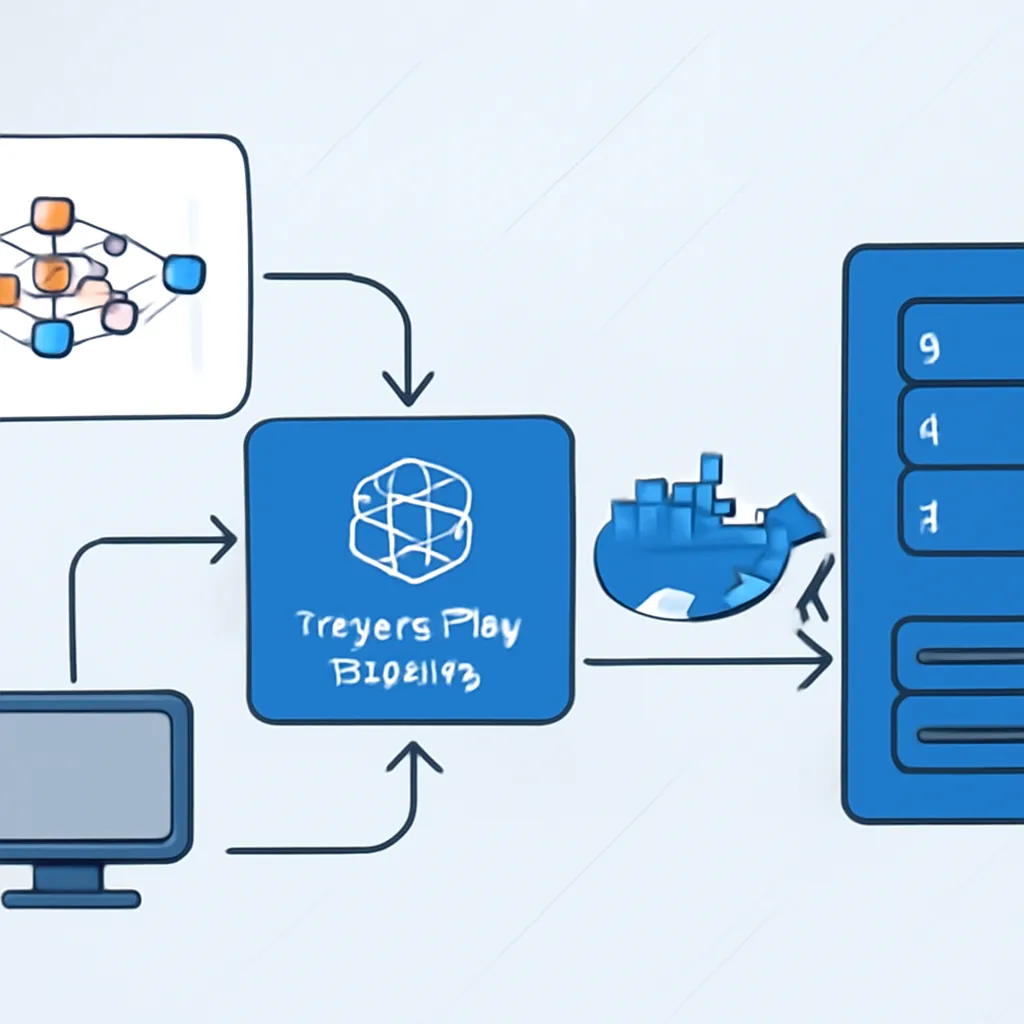

TensorFlow Serving es una infraestructura flexible y de alto rendimiento para desplegar modelos de aprendizaje automático en producción. Permite servir modelos entrenados para realizar inferencias vía API REST o gRPC, facilitando la integración con aplicaciones backend o móviles.

Por su parte, Docker es una plataforma que permite empaquetar aplicaciones y sus dependencias en contenedores ligeros y portables, asegurando que el entorno de ejecución sea el mismo en cualquier máquina.

Combinar TensorFlow Serving con Docker facilita la despliegue de modelos en entornos controlados, con alta escalabilidad y rápida puesta en marcha.

Preparación del Modelo TensorFlow para TensorFlow Serving

Para utilizar TensorFlow Serving, el modelo debe estar exportado en formato SavedModel. Este formato contiene toda la información necesaria para la inferencia. Un ejemplo básico para exportar un modelo entrenado:

import tensorflow as tf

# Suponemos que ya tienes un modelo entrenado

model = ... # tu modelo TensorFlow

# Ruta donde guardaremos el modelo

export_path = './exported_model/1'

# Guardar el modelo en formato SavedModel

model.save(export_path, save_format='tf')Fíjate en que la versión del modelo debe estar en una carpeta con nombre numérico (p.ej., 1), para facilitar la gestión de versiones en TensorFlow Serving.

Configuración del contenedor Docker para TensorFlow Serving

TensorFlow Serving ofrece imágenes oficiales en Docker Hub que puedes utilizar directamente. Para probar localmente el servidor con tu modelo, ejecuta:

docker pull tensorflow/servingLuego, en la terminal, ejecuta un contenedor enlazando el modelo exportado:

docker run -p 8501:8501 \

--mount type=bind,source=$(pwd)/exported_model,target=/models/my_model \

-e MODEL_NAME=my_model -t tensorflow/servingExplicación:

-p 8501:8501expone el puerto para solicitudes REST.--mountconecta la ruta local donde está el modelo con el contenedor.-e MODEL_NAME=my_modelindica el nombre del modelo que TensorFlow Serving usará.

Realizando una Inferencia de Prueba: Cliente REST en Python

Una vez el servidor está activo, podemos enviar peticiones para obtener predicciones. Supongamos que tienes un modelo que toma vectores con 4 características (por ejemplo, datos de iris). El siguiente código envía una predicción usando requests:

import json

import requests

# URL del endpoint REST

url = 'http://localhost:8501/v1/models/my_model:predict'

# Datos de entrada (batch de 2 muestras con 4 características cada una)

data = {

"instances": [

[5.1, 3.5, 1.4, 0.2],

[6.7, 3.0, 5.2, 2.3]

]

}

# Realizamos la petición POST

response = requests.post(url, data=json.dumps(data))

print('Resultado:', response.json())Si el modelo está bien cargado, recibirás una predicción para ambas entradas.

Automatización con Docker Compose

Para simplificar la gestión, especialmente si después conectas bases de datos o APIs adicionales, puedes usar docker-compose. Aquí tienes un ejemplo básico para lanzar el servidor TensorFlow Serving:

version: '3.8'

services:

tf_serving:

image: tensorflow/serving

ports:

- 8501:8501

volumes:

- ./exported_model:/models/my_model

environment:

- MODEL_NAME=my_model

Con este archivo docker-compose.yml, sólo debes ejecutar docker-compose up y tener tu servicio listo.

Buenas prácticas y recomendaciones finales

- Versiona tus modelos: Cambia el número de la carpeta para actualizar modelos sin detener el servicio.

- Monitoriza el consumo: TensorFlow Serving permite métricas para supervisar la performance.

- Usa gRPC para producción: Aunque REST es sencillo, gRPC ofrece menor latencia y mejor eficiencia.

- Automatiza pruebas: Integra tests que validen que las respuestas de inferencia son correctas tras despliegues.

- Escala con Kubernetes: Considera orquestar el servicio en clusters para alta disponibilidad.

Conclusión

Desplegar modelos TensorFlow con TensorFlow Serving y Docker es una forma efectiva de llevar tus modelos desde el entorno de desarrollo hasta producción, manteniendo consistencia, escalabilidad y buen rendimiento. Con esta guía práctica has visto cómo exportar un modelo, configurar el servidor Docker, realizar inferencias y automatizar el despliegue con docker-compose. Estas son las bases para crear pipelines robustos que en escenarios reales pueden ir desde simple APIs hasta complejos sistemas de IA en producción.