Introducción a la Computación Neuromórfica: El Futuro de la Arquitectura de IA

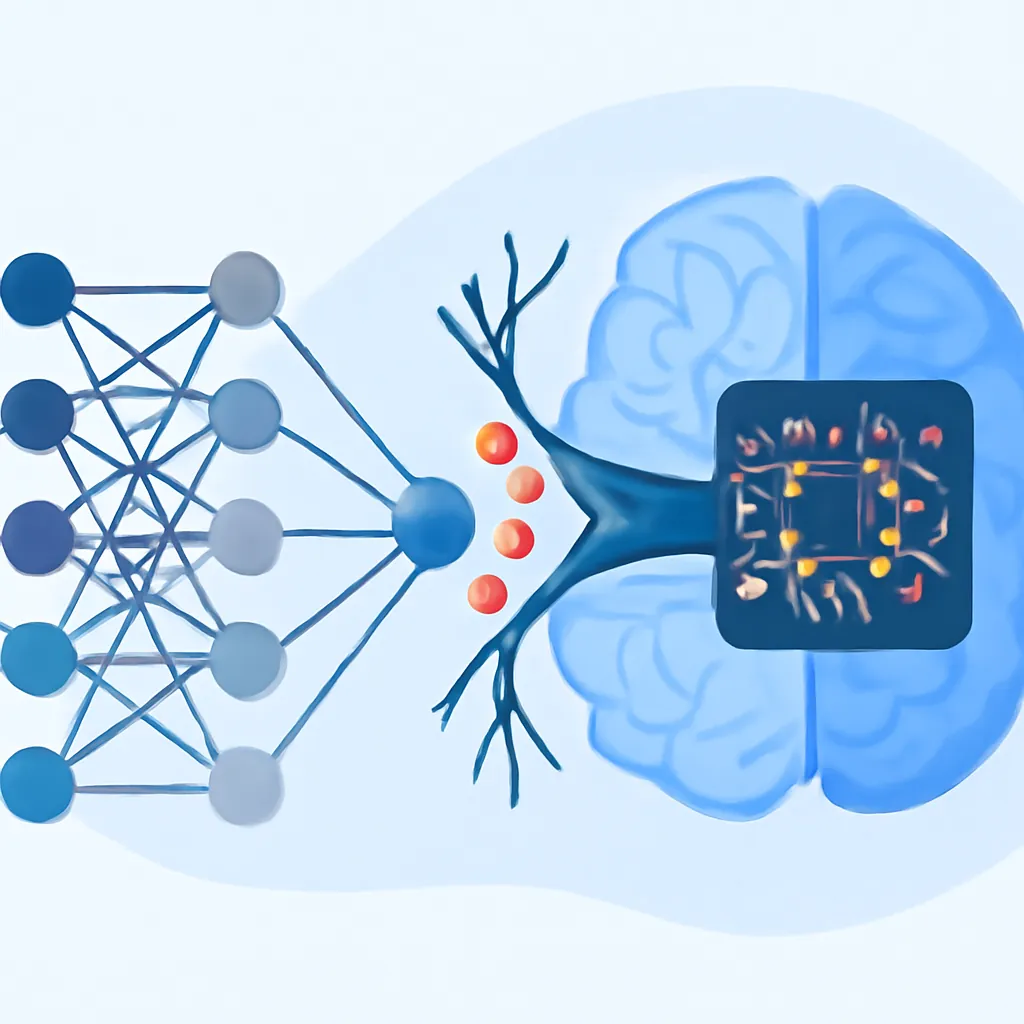

La Computación Neuromórfica representa una revolución en la manera en que diseñamos sistemas de inteligencia artificial y hardware para procesar información. Inspirada en la estructura y funcionamiento del cerebro humano, esta tecnología busca superar limitaciones de los sistemas convencionales, logrando eficiencia energética, procesamiento en paralelo y adaptabilidad.

En este artículo introductorio, dirigido a lectores con conocimientos intermedios en IA y arquitectura computacional, exploraremos los fundamentos de la computación neuromórfica, su comparación con arquitecturas tradicionales y sus aplicaciones prácticas emergentes.

¿Qué es la Computación Neuromórfica?

La computación neuromórfica es un paradigma de diseño de hardware y software inspirado en la anatomía y fisiología del sistema nervioso biológico, específicamente el cerebro. Mientras la mayoría de las computadoras actuales están basadas en la arquitectura Von Neumann —que separa memoria de procesamiento—, los sistemas neuromórficos integran ambas funciones emulando redes de neuronas y sinapsis.

Esto permite una gran eficiencia en el procesamiento paralelo, alta velocidad en tareas específicas y un consumo energético significativamente menor.

Principales Componentes de un Sistema Neuromórfico

- Neurona artificial: Unidad que emula el comportamiento de una neurona biológica, capaz de integrar señales y disparar eventos cuando se supera un umbral.

- Sinapsis artificial: Canales de comunicación entre neuronas, modulables para ajustar la fuerza de la conexión (peso sináptico).

- Módulos de memoria local: Alojados cerca de las neuronas para evitar la latencia de transferencias constantes.

- Mecanismos de plasticidad: Algoritmos que permiten el aprendizaje adaptativo y la modificación dinámica de conexiones, inspirados en fenómenos biológicos como el aprendizaje Hebbiano.

Comparación con Arquitectura Convencional Von Neumann

| Característica | Arquitectura Von Neumann | Computación Neuromórfica |

|---|---|---|

| Estructura | Separación clara entre CPU y memoria | Integración estrecha de memoria y procesamiento |

| Procesamiento | Secuencial o con cierto paralelismo limitado | Procesamiento masivo y paralelo inspirado en redes neuronales |

| Consumo energético | Relativamente alto para problemas complejos de IA | Muy bajo, diseñado para eficiencia en tareas cognitivas |

| Flexibilidad | Alta, general purpose | Especializado en tareas específicas de procesamiento neuronal y aprendizaje |

Tecnologías y Chips Neuromórficos Actuales

Varias iniciativas y productos destacados en computación neuromórfica incluyen:

- Loihi de Intel: Un chip neuromórfico que implementa más de un millón de neuronas artificiales con learning online mediante spike-timing dependent plasticity.

- TrueNorth de IBM: Arquitectura que simula más de un millón de neuronas y miles de millones de sinapsis, con bajo consumo energético.

- Neuronas y sinapsis memristivas: Dispositivos nanoelectrónicos que almacenan y procesan información de modo analógico, emulando el comportamiento sináptico.

Aplicaciones Prácticas y Futuro

Los sistemas neuromórficos están emergiendo en áreas donde la eficiencia y rapidez de procesamiento son críticas:

- Robótica autónoma: Robots con sistemas de percepción y toma de decisiones rápidos y de bajo consumo.

- Dispositivos IoT inteligentes: Sensores con capacidad de análisis local en tiempo real.

- Procesamiento sensorial en tiempo real: Reconocimiento de voz, visión artificial y análisis de señales bioeléctricas.

- Neuroprótesis y interfaces cerebro-máquina: Implementación de sistemas que interactúan directamente con el sistema nervioso humano.

La computación neuromórfica promete ser la clave para superar limitaciones actuales, logrando sistemas que, al emular la eficiencia del cerebro, puedan potenciar nuevas generaciones de IA y máquinas inteligentes.

Ejemplo Práctico: Simulando una neurona Integrate-and-Fire en Python

A continuación, un sencillo código que representa el comportamiento básico de una neurona Integrate-and-Fire, un modelo común en sistemas neuromórficos:

import numpy as np

import matplotlib.pyplot as plt

class IntegrateAndFireNeuron:

def __init__(self, threshold=1.0, decay=0.95):

self.potential = 0.0

self.threshold = threshold

self.decay = decay

self.spike_times = []

def step(self, input_current, t):

self.potential = self.potential * self.decay + input_current

if self.potential >= self.threshold:

self.potential = 0.0

self.spike_times.append(t)

return 1

return 0

# Simulación

neuron = IntegrateAndFireNeuron()

time = np.arange(0, 100)

inputs = np.random.rand(100) * 0.5 # Entrada aleatoria

spikes = []

for t in time:

spike = neuron.step(inputs[t], t)

spikes.append(spike)

plt.plot(time, spikes, '|')

plt.title('Simulación Neurona Integrate-and-Fire')

plt.xlabel('Tiempo')

plt.ylabel('Spike (1=disparo)')

plt.show()Este código muestra cómo una neurona acumula una entrada, la decae, y genera un disparo (spike) al superar un umbral, emulando un comportamiento básico de neuronas biológicas.

Conclusión

La computación neuromórfica fusiona neurociencia e ingeniería para diseñar sistemas de inteligencia artificial que van más allá del paradigma clásico. Su potencial para transformar ámbitos como la robótica, la interacción hombre-máquina y el procesamiento eficiente de datos es enorme.

Comprender sus fundamentos y tecnologías actuales permite a investigadores y desarrolladores anticipar la próxima ola en la evolución del hardware y software de IA.