Redes Neuronales Gráficas (GNNs): Arquitecturas Avanzadas y Aplicaciones Prácticas para Datos Estructurados

Explora el poder de las GNNs para modelar relaciones complejas en datos no euclidianos. Un análisis profundo de sus fundamentos, arquitecturas clave y una implementación práctica con PyTorch Geometric para desarrolladores y profesionales de IA.

Introducción: Más Allá de los Datos Tabulares y Secuenciales

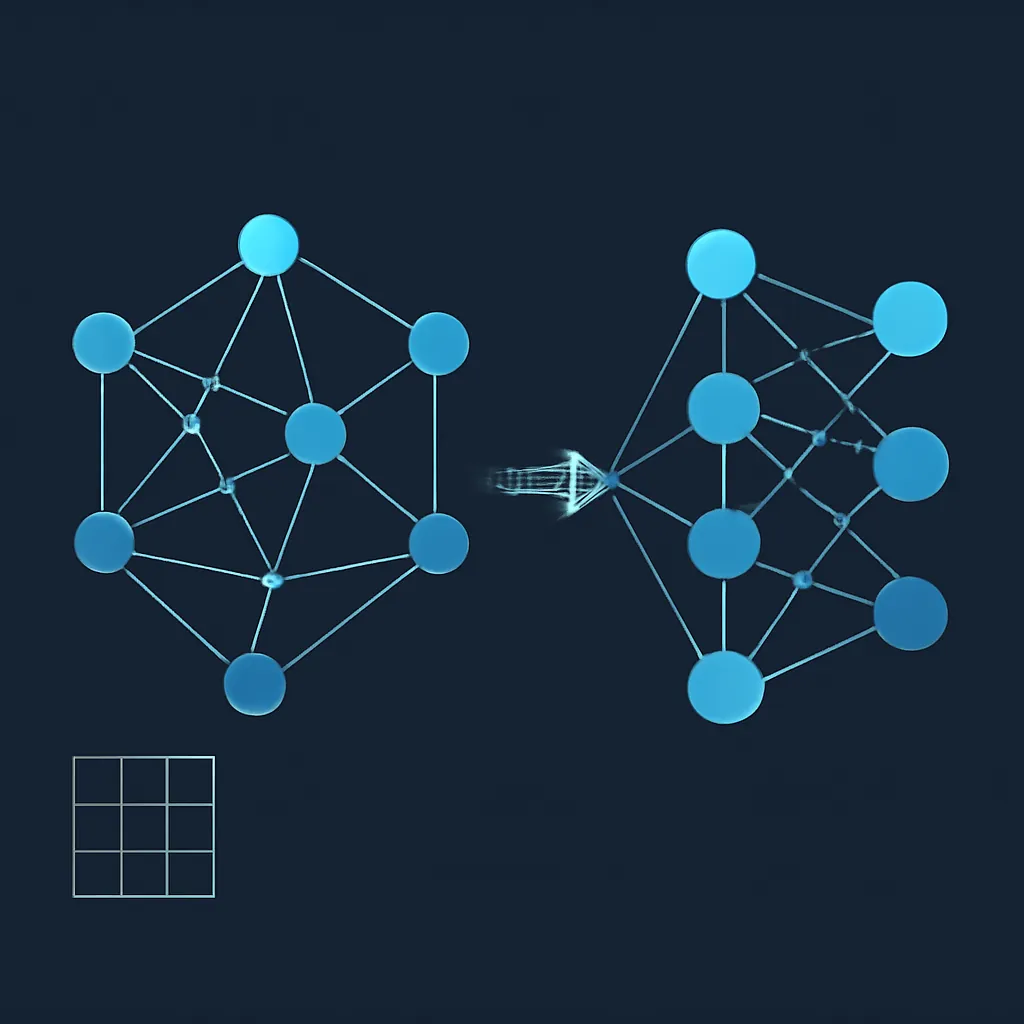

En el vasto universo de la Inteligencia Artificial, la mayoría de los modelos de Deep Learning han brillado en el procesamiento de datos estructurados de forma euclidiana, como imágenes (con CNNs) o secuencias de texto (con RNNs y Transformers). Sin embargo, una cantidad significativa de datos en el mundo real no encaja en estas estructuras rígidas. Pensemos en redes sociales, moléculas químicas, redes de transporte, o incluso el cerebro humano: todos son inherentemente estructuras de grafo, donde las entidades (nodos) están interconectadas por relaciones (aristas).

Aquí es donde entran en juego las Redes Neuronales Gráficas (GNNs). Las GNNs son una clase de arquitecturas de redes neuronales profundas diseñadas específicamente para operar directamente sobre datos estructurados como grafos, capturando tanto las características de los nodos como la topología de las conexiones. [2, 4, 18] Su capacidad para modelar dependencias complejas y relaciones no lineales las ha convertido en una herramienta indispensable para problemas que antes eran intratables con los métodos tradicionales de Machine Learning. [6, 12]

Este artículo está dirigido a desarrolladores y profesionales de IA con una base sólida en Deep Learning, que buscan expandir sus conocimientos hacia el procesamiento de datos en grafos. Profundizaremos en los principios fundamentales de las GNNs, exploraremos sus arquitecturas más influyentes y, lo más importante, proporcionaremos un ejemplo práctico y funcional utilizando la popular librería PyTorch Geometric.

Fundamentos de las Redes Neuronales Gráficas: El Paradigma del Paso de Mensajes

El corazón de la mayoría de las arquitecturas GNN reside en el concepto de paso de mensajes (message passing). [1, 2, 3, 14] A diferencia de las redes neuronales tradicionales que procesan entradas fijas, las GNNs actualizan las representaciones (embeddings) de cada nodo de forma iterativa, agregando información de sus nodos vecinos. [2, 3, 14]

Cada iteración o capa de una GNN implica dos pasos principales para cada nodo v:

- Agregación (Aggregate): Se recopilan los mensajes (generalmente las representaciones de los nodos vecinos) y, opcionalmente, las características de las aristas. Esta información se combina utilizando una función de agregación (ej. suma, promedio, máximo). [14]

-

Actualización (Update): La representación del nodo

vse actualiza combinando su representación anterior con el mensaje agregado de sus vecinos. Esto se hace típicamente con una red neuronal (MLP) o una función no lineal. [14]

Este proceso se repite durante varias capas, permitiendo que la información se propague a través del grafo, y que cada nodo incorpore información de vecinos cada vez más lejanos en su campo receptivo. [3]

Representación de Grafos para GNNs

Para que una GNN pueda procesar un grafo, necesitamos representarlo numéricamente. Los componentes clave son:

- Nodos (Vertices): Entidades en el grafo. Cada nodo

vtiene un vector de características inicialx_v. [4, 18] - Aristas (Edges): Conexiones entre nodos. Pueden ser dirigidas o no dirigidas, y también pueden tener características

e_uv. [4, 18] - Matriz de Adyacencia (Adjacency Matrix): Una representación matricial

AdondeA_ij = 1si hay una arista entre el nodoiy el nodoj, y0en caso contrario. [18]

El objetivo de una GNN es aprender una representación (embedding) de la estructura del grafo que capture tanto las propiedades de los nodos como la topología del grafo. [4]

Arquitecturas Clave de GNNs

El campo de las GNNs ha evolucionado rápidamente, dando lugar a diversas arquitecturas, cada una con sus propias fortalezas. [1, 5] A continuación, exploramos algunas de las más influyentes:

1. Graph Convolutional Networks (GCNs)

Las GCNs son una de las arquitecturas más fundamentales y populares, extendiendo el concepto de convoluciones de CNNs a grafos. [1, 4, 5, 18] La idea central es actualizar la representación de un nodo agregando y transformando las características de sus nodos vecinos y de sí mismo. [4]

La operación de una capa GCN se puede formular de la siguiente manera:

H^(l+1) = σ(D^(-1/2) * A_hat * D^(-1/2) * H^(l) * W^(l))

H^(l): Matriz de características de los nodos en la capal.A_hat = A + I: Matriz de adyacencia con auto-bucles (para incluir la característica del propio nodo).D: Matriz de grados diagonal deA_hat.W^(l): Matriz de pesos entrenable para la capal.σ: Función de activación (ej. ReLU).

Esta formulación normaliza la agregación de características, evitando que los nodos con muchos vecinos dominen la actualización. [4]

2. GraphSAGE (Graph Sample and Aggregate)

GraphSAGE aborda el problema de la escalabilidad en grafos grandes, donde el cálculo de la representación de un nodo puede depender de su vecindario completo, lo cual es ineficiente. [5] En lugar de usar todos los vecinos, GraphSAGE muestrea un subconjunto de vecinos y luego agrega sus características. Esto permite que el modelo sea inductivo, es decir, que pueda generalizar a nodos no vistos durante el entrenamiento. [16]

3. Graph Attention Networks (GATs)

Las GATs introducen un mecanismo de atención en el proceso de agregación. [14] En lugar de tratar a todos los vecinos por igual (como en las GCNs básicas), las GATs calculan pesos de atención para cada par nodo-vecino, permitiendo que el modelo aprenda la importancia relativa de cada vecino en la agregación. [14] Esto mejora la expresividad del modelo y su capacidad para manejar grafos heterogéneos.

Aplicaciones Prácticas de las GNNs

Las GNNs han demostrado ser excepcionalmente versátiles en una amplia gama de dominios, resolviendo problemas complejos que involucran datos relacionales. [1, 2, 4, 18]

- Clasificación de Nodos: Predecir la categoría o etiqueta de un nodo individual en un grafo. Ejemplos incluyen la clasificación de usuarios en redes sociales por intereses o la categorización de documentos en una red de citas. [1, 4, 19]

- Predicción de Enlaces: Predecir la existencia o la probabilidad de una conexión entre dos nodos. [1, 4, 18] Crucial en sistemas de recomendación (sugerir amigos o productos) o en el descubrimiento de fármacos (predecir interacciones moleculares). [1, 12, 22]

- Clasificación de Grafos: Clasificar un grafo completo. [4, 18] Utilizado en química para predecir propiedades de moléculas (donde cada molécula es un grafo) o en bioinformática para clasificar proteínas. [1, 4, 12]

- Detección de Anomalías: Identificar patrones inusuales en grafos, como transacciones fraudulentas en redes financieras.

- Visión por Computadora: Procesar imágenes como grafos para detección de objetos o comprensión de escenas. [1, 2]

- Procesamiento del Lenguaje Natural (NLP): Modelar relaciones entre palabras o entidades en texto. [1]

- Bioinformática: Análisis de redes genéticas, interacción de proteínas y descubrimiento de fármacos. [2, 12]

Implementación Práctica: Clasificación de Nodos con PyTorch Geometric

Para ilustrar el poder de las GNNs, implementaremos un modelo GCN simple para la clasificación de nodos utilizando la librería PyTorch Geometric (PyG). PyG es una extensión de PyTorch que facilita la implementación de GNNs gracias a sus estructuras de datos optimizadas y módulos predefinidos. [11, 17]

Configuración del Entorno

Primero, asegúrate de tener PyTorch y PyTorch Geometric instalados:

pip install torch torch_geometric

Para este ejemplo, usaremos el dataset Cora, una red de citas donde los nodos son documentos y las aristas son citas. La tarea es clasificar cada documento en una de varias categorías. [19]

Código Paso a Paso

import torch

import torch.nn.functional as F

from torch_geometric.nn import GCNConv

from torch_geometric.datasets import Planetoid

# 1. Cargar el Dataset Cora

# El dataset Planetoid incluye Cora, CiteSeer y PubMed

dataset = Planetoid(root='/tmp/Cora', name='Cora')

data = dataset[0]

print(f'Número de nodos: {data.num_nodes}')

print(f'Número de aristas: {data.num_edges}')

print(f'Número de características de nodos: {data.num_node_features}')

print(f'Número de clases: {dataset.num_classes}')

print(f'¿El grafo tiene auto-bucles?: {data.contains_self_loops()}')

print(f'¿El grafo es dirigido?: {data.is_directed()}')

# 2. Definir el Modelo GCN

class GCN(torch.nn.Module):

def __init__(self, in_channels, hidden_channels, out_channels):

super().__init__()

# Primera capa convolucional de grafo

# GCNConv toma las características de entrada y la matriz de adyacencia

self.conv1 = GCNConv(in_channels, hidden_channels)

# Segunda capa convolucional de grafo

self.conv2 = GCNConv(hidden_channels, out_channels)

def forward(self, x, edge_index):

# Aplicar la primera capa GCN, seguida de ReLU y dropout

x = self.conv1(x, edge_index)

x = F.relu(x)

x = F.dropout(x, p=0.5, training=self.training)

# Aplicar la segunda capa GCN

x = self.conv2(x, edge_index)

return x

# Inicializar el modelo

model = GCN(in_channels=dataset.num_node_features,

hidden_channels=16, # Un tamaño oculto común

out_channels=dataset.num_classes)

# 3. Definir la función de pérdida y el optimizador

optimizer = torch.optim.Adam(model.parameters(), lr=0.01, weight_decay=5e-4)

criterion = torch.nn.CrossEntropyLoss()

# 4. Función de Entrenamiento

def train():

model.train() # Poner el modelo en modo entrenamiento

optimizer.zero_grad() # Limpiar gradientes

out = model(data.x, data.edge_index) # Forward pass

# Calcular la pérdida solo en los nodos de entrenamiento

loss = criterion(out[data.train_mask], data.y[data.train_mask])

loss.backward() # Backward pass

optimizer.step() # Actualizar pesos

return loss.item()

# 5. Función de Prueba/Evaluación

def test():

model.eval() # Poner el modelo en modo evaluación

out = model(data.x, data.edge_index)

# Calcular la precisión en los nodos de prueba y validación

pred = out.argmax(dim=1) # Obtener la clase predicha

# Precisión en el conjunto de validación

correct_val = pred[data.val_mask] == data.y[data.val_mask]

acc_val = int(correct_val.sum()) / int(data.val_mask.sum())

# Precisión en el conjunto de prueba

correct_test = pred[data.test_mask] == data.y[data.test_mask]

acc_test = int(correct_test.sum()) / int(data.test_mask.sum())

return acc_val, acc_test

# 6. Bucle de Entrenamiento

epochs = 200

for epoch in range(1, epochs + 1):

loss = train()

acc_val, acc_test = test()

if epoch % 20 == 0 or epoch == 1:

print(f'Epoch: {epoch:03d}, Loss: {loss:.4f}, Val Acc: {acc_val:.4f}, Test Acc: {acc_test:.4f}')

print('\nEntrenamiento finalizado.')

acc_val, acc_test = test()

print(f'Precisión final en Validación: {acc_val:.4f}')

print(f'Precisión final en Prueba: {acc_test:.4f}')

Este código demuestra cómo construir, entrenar y evaluar una GCN para la clasificación de nodos. La clave está en cómo GCNConv maneja la agregación de características de los vecinos y la propagación de la información a través de las capas.

Desafíos y Futuro de las GNNs

A pesar de su éxito, las GNNs aún enfrentan varios desafíos que son áreas activas de investigación: [6, 7, 9, 10]

- Escalabilidad: Entrenar GNNs en grafos masivos (con miles de millones de nodos y aristas) sigue siendo un reto computacional. Técnicas como el muestreo de vecinos (GraphSAGE) o el muestreo de subgrafos (GraphSAINT) buscan mitigar esto. [5, 16]

- Generalización: La capacidad de una GNN entrenada en un grafo para generalizar a grafos completamente nuevos con estructuras diferentes es limitada. [4, 9]

- Heterogeneidad y Dinamismo: Modelar grafos con múltiples tipos de nodos y aristas (grafos heterogéneos) o grafos que cambian con el tiempo (grafos dinámicos/temporales) es más complejo. [4, 6, 16]

- Interpretabilidad: Entender por qué una GNN toma una decisión particular es crucial en aplicaciones sensibles como la medicina o las finanzas. [4, 6, 10]

- Over-smoothing: En GNNs profundas, las representaciones de los nodos tienden a volverse indistinguibles, perdiendo información local.

El futuro de las GNNs es prometedor, con investigación enfocada en arquitecturas más robustas, métodos de muestreo más eficientes, integración con aprendizaje por refuerzo y técnicas de auto-supervisión, y una mayor interpretabilidad. [7, 9]

Conclusión

Las Redes Neuronales Gráficas representan un avance significativo en el campo del Deep Learning, abriendo la puerta a la resolución de problemas complejos en dominios donde los datos se estructuran naturalmente como grafos. [18] Su capacidad para capturar y explotar las relaciones intrínsecas entre entidades las distingue de las arquitecturas tradicionales.

Como desarrolladores y profesionales de IA, comprender y dominar las GNNs es cada vez más vital para abordar desafíos en áreas como las redes sociales, la química, la biología, los sistemas de recomendación y más. Aunque aún existen desafíos, la investigación activa y el desarrollo de librerías como PyTorch Geometric y DGL [16, 17] están democratizando su uso y expandiendo sus horizontes. El camino hacia una IA más inteligente y contextualizada pasa, sin duda, por el aprendizaje en grafos.