Testing para APIs de IA con FastAPI y Pytest: Garantizando la Robustez y Fiabilidad

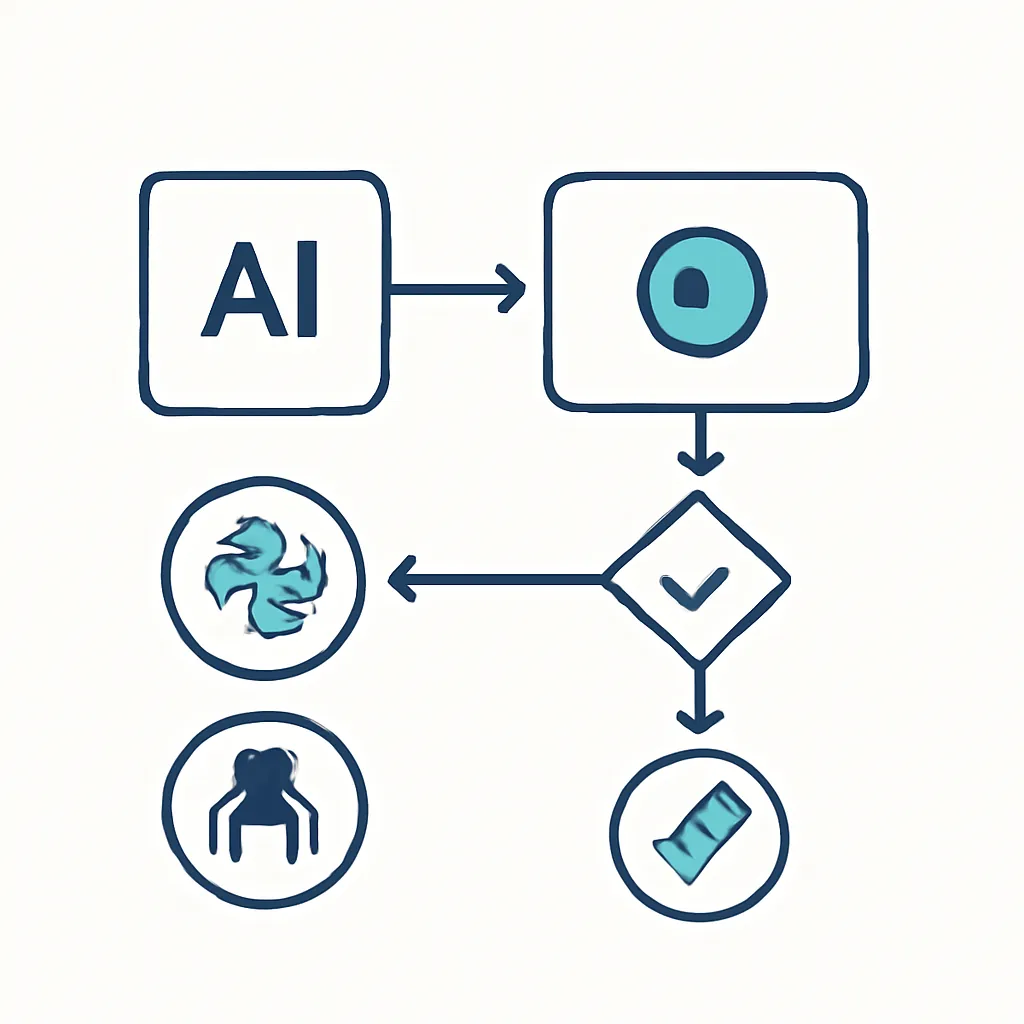

En el vertiginoso mundo del desarrollo de Inteligencia Artificial, no basta con crear modelos innovadores o APIs que respondan. La fiabilidad, la robustez y la capacidad de mantenimiento son tan cruciales como la funcionalidad misma. Aquí es donde el testing se convierte en tu mejor aliado, especialmente cuando construyes APIs inteligentes con FastAPI y Python. Este artículo te guiará a través de las mejores prácticas para asegurar la calidad de tus APIs de IA, utilizando Pytest para pruebas unitarias y de integración, y técnicas de mocking para manejar dependencias externas como modelos de IA o servicios de terceros.

Contexto del Problema: La Necesidad de Tests en APIs de IA

Desarrollar una API de IA es un proceso complejo que involucra múltiples capas: desde la ingesta y preprocesamiento de datos, la inferencia del modelo, hasta la exposición de resultados a través de endpoints HTTP. Cada una de estas capas es un punto potencial de fallo. Un error en el preprocesamiento puede llevar a inferencias incorrectas, una validación de entrada deficiente puede exponer tu API a ataques, y una integración defectuosa con un modelo de IA puede resultar en respuestas inesperadas o caídas del servicio.

Sin una estrategia de testing sólida, depurar estos problemas en producción puede ser una pesadilla, consumiendo tiempo valioso y recursos. Los tests automatizados te permiten detectar errores temprano en el ciclo de desarrollo, refactorizar con confianza y asegurar que los cambios futuros no introduzcan nuevas regresiones. Para los desarrolladores junior-mid, comprender y aplicar estas técnicas es fundamental para construir aplicaciones de IA de calidad profesional.

Conceptos Clave para un Testing Efectivo

Antes de sumergirnos en el código, es importante entender algunos conceptos fundamentales del testing:

Tipos de Testing

- Tests Unitarios: Se centran en probar las unidades más pequeñas y aisladas de tu código (funciones, métodos, clases). El objetivo es verificar que cada componente individual funciona como se espera.

- Tests de Integración: Verifican que diferentes módulos o servicios de tu aplicación funcionan correctamente cuando se combinan. En el contexto de FastAPI, esto podría significar probar la interacción entre un endpoint y una función de lógica de negocio, o entre la API y una base de datos.

- Tests Funcionales/End-to-End (E2E): Simulan el comportamiento del usuario final para verificar que el sistema completo cumple con los requisitos funcionales. Para una API, esto implicaría enviar solicitudes HTTP reales y verificar las respuestas.

Pytest: Tu Framework de Testing de Confianza

Pytest es un framework de testing popular en Python conocido por su simplicidad y extensibilidad. Algunas de sus características clave incluyen:

- Detección automática de tests: Busca archivos que comienzan con

test_o terminan con_test.pyy funciones que comienzan contest_. [25] - Fixtures: Funciones especiales que se utilizan para configurar un entorno de prueba (por ejemplo, inicializar una base de datos, crear un cliente HTTP). Pueden tener diferentes alcances (función, módulo, sesión) para controlar su ciclo de vida. [12]

- Asserts sencillos: Utiliza las sentencias

assertestándar de Python para verificar condiciones. - Plugins: Una vasta colección de plugins para extender su funcionalidad (ej.

pytest-covpara cobertura de código,pytest-mockpara mocking).

FastAPI TestClient

FastAPI proporciona un TestClient que te permite interactuar con tu aplicación FastAPI directamente, sin necesidad de ejecutar un servidor HTTP real. [2, 4, 6] Esto hace que los tests sean mucho más rápidos y fiables. El TestClient se basa en la librería httpx y simula el envío de solicitudes HTTP a tu aplicación, permitiéndote inspeccionar las respuestas. [2]

Mocks para Modelos de IA y APIs Externas

Cuando tu API de IA interactúa con modelos de Machine Learning (ML) o servicios externos (como la API de OpenAI, bases de datos vectoriales, etc.), es crucial "mockear" estas dependencias durante los tests. Mockear significa reemplazar un objeto real por uno simulado que imita su comportamiento. Esto tiene varias ventajas:

- Aislamiento: Tus tests se centran solo en la lógica de tu API, sin depender de la disponibilidad o el rendimiento de servicios externos. [26]

- Velocidad: Evita las latencias de red y los tiempos de inferencia de modelos reales, haciendo que los tests sean mucho más rápidos. [9]

- Costo: Evita consumir tokens o recursos de APIs de pago durante el desarrollo y testing. [9]

- Simulación de errores: Permite simular fácilmente escenarios de error (ej. fallos de red, respuestas inesperadas de la API externa) para probar cómo tu aplicación los maneja. [9]

La librería unittest.mock de Python, a menudo utilizada con pytest-mock, es excelente para esto. [29]

Validación de Datos con Pydantic en Tests

FastAPI utiliza Pydantic para la validación y serialización de datos. [10, 22, 27] Es importante que tus tests verifiquen que tus modelos Pydantic manejan correctamente las entradas válidas e inválidas, y que la API devuelve los errores de validación esperados (código de estado 422). [10]

Implementación Paso a Paso: Construyendo una API de IA Testeable

Vamos a construir una pequeña API FastAPI que simula una inferencia de IA y luego escribiremos tests robustos para ella.

1. Configuración del Entorno

Primero, crea un nuevo directorio para tu proyecto y un entorno virtual:

mkdir ia-api-testing

cd ia-api-testing

python -m venv .venv

source .venv/bin/activate # En Windows: .venv\Scripts\activate

pip install fastapi uvicorn pytest httpx pytest-mock pydantic

2. Estructura del Proyecto

Organiza tu proyecto de la siguiente manera:

ia-api-testing/

├── app/

│ ├── __init__.py

│ ├── main.py

│ └── models.py

├── tests/

│ ├── __init__.py

│ ├── conftest.py

│ └── test_main.py

└── requirements.txt

3. Definición de Modelos Pydantic (app/models.py)

Definimos los modelos para la entrada y salida de nuestra API.

from pydantic import BaseModel, Field

from typing import List, Optional

class TextAnalysisRequest(BaseModel):

text: str = Field(..., min_length=10, max_length=500, description="Texto a analizar por la IA.")

class SentimentResult(BaseModel):

label: str = Field(..., description="Etiqueta de sentimiento (positivo, negativo, neutral).")

score: float = Field(..., ge=0.0, le=1.0, description="Puntuación de confianza del sentimiento.")

class TextAnalysisResponse(BaseModel):

original_text: str

sentiment: SentimentResult

keywords: List[str]

model_version: str

4. Implementación de la API FastAPI (app/main.py)

Nuestra API tendrá un endpoint que simula el análisis de texto por una IA.

from fastapi import FastAPI, HTTPException, status

from app.models import TextAnalysisRequest, TextAnalysisResponse, SentimentResult

import asyncio

import os

app = FastAPI(title="API de Análisis de Texto con IA")

# Simulación de un "modelo" de IA externo

async def mock_ai_inference(text: str) -> dict:

"""Simula una llamada asíncrona a un modelo de IA externo."""

await asyncio.sleep(0.1) # Simula latencia de red/procesamiento

if "error" in text.lower():

raise ValueError("Error simulado en la inferencia del modelo.")

# Lógica de inferencia muy simplificada

sentiment_label = "neutral"

sentiment_score = 0.5

if "excelente" in text.lower() or "genial" in text.lower():

sentiment_label = "positivo"

sentiment_score = 0.9

elif "malo" in text.lower() or "terrible" in text.lower():

sentiment_label = "negativo"

sentiment_score = 0.8

keywords = [word for word in text.lower().split() if len(word) > 4 and word not in ["el", "la", "los", "las", "un", "una", "unos", "unas", "es", "de", "en", "con"]]

return {

"sentiment": {"label": sentiment_label, "score": sentiment_score},

"keywords": list(set(keywords)), # Eliminar duplicados

"model_version": os.getenv("AI_MODEL_VERSION", "v1.0.0")

}

@app.post("/analyze", response_model=TextAnalysisResponse, status_code=status.HTTP_200_OK)

async def analyze_text(request: TextAnalysisRequest):

"""Realiza un análisis de sentimiento y extracción de palabras clave de un texto."""

try:

inference_result = await mock_ai_inference(request.text)

sentiment_data = SentimentResult(**inference_result["sentiment"])

return TextAnalysisResponse(

original_text=request.text,

sentiment=sentiment_data,

keywords=inference_result["keywords"],

model_version=inference_result["model_version"]

)

except ValueError as e:

raise HTTPException(status_code=status.HTTP_400_BAD_REQUEST, detail=str(e))

except Exception as e:

raise HTTPException(status_code=status.HTTP_500_INTERNAL_SERVER_ERROR, detail="Error interno del servidor.")

5. Configuración de Pytest y Fixtures (tests/conftest.py)

Aquí definimos un fixture para el TestClient de FastAPI, que será reutilizado por todos nuestros tests. [2, 12]

import pytest

from fastapi.testclient import TestClient

from app.main import app

@pytest.fixture(scope="module")

def client():

"""Fixture para el TestClient de FastAPI."""

with TestClient(app) as c:

yield c

6. Escribiendo Tests (tests/test_main.py)

Ahora, crearemos nuestros tests utilizando Pytest y el TestClient.

import pytest

from unittest.mock import patch, AsyncMock

from fastapi import status

from app.models import TextAnalysisRequest, TextAnalysisResponse, SentimentResult

# El fixture 'client' se inyecta automáticamente desde conftest.py

def test_analyze_text_success(client):

"""Prueba el endpoint /analyze con una entrada válida y mockeando la inferencia de IA."""

test_text = "Este es un texto excelente y genial para analizar."

expected_response_data = {

"sentiment": {"label": "positivo", "score": 0.9},

"keywords": ["texto", "excelente", "genial", "analizar"],

"model_version": "v1.0.0"

}

# Mockeamos la función asíncrona mock_ai_inference

with patch("app.main.mock_ai_inference", new_callable=AsyncMock) as mock_inference:

mock_inference.return_value = expected_response_data

response = client.post(

"/analyze",

json={"text": test_text}

)

assert response.status_code == status.HTTP_200_OK

response_json = response.json()

assert response_json["original_text"] == test_text

assert response_json["sentiment"] == expected_response_data["sentiment"]

assert set(response_json["keywords"]) == set(expected_response_data["keywords"])

assert response_json["model_version"] == expected_response_data["model_version"]

mock_inference.assert_called_once_with(test_text)

def test_analyze_text_invalid_input_short(client):

"""Prueba el endpoint /analyze con un texto demasiado corto."""

response = client.post(

"/analyze",

json={"text": "corto"}

)

assert response.status_code == status.HTTP_422_UNPROCESSABLE_ENTITY

assert "ensure this value has at least 10 characters" in response.json()["detail"][0]["msg"]

def test_analyze_text_invalid_input_long(client):

"""Prueba el endpoint /analyze con un texto demasiado largo."""

long_text = "a" * 501 # Más de 500 caracteres

response = client.post(

"/analyze",

json={"text": long_text}

)

assert response.status_code == status.HTTP_422_UNPROCESSABLE_ENTITY

assert "ensure this value has at most 500 characters" in response.json()["detail"][0]["msg"]

def test_analyze_text_ai_inference_error(client):

"""Prueba el manejo de errores cuando la inferencia de IA falla."""

test_text_with_error = "Este texto causará un error en la IA."

with patch("app.main.mock_ai_inference", new_callable=AsyncMock) as mock_inference:

mock_inference.side_effect = ValueError("Error simulado en la inferencia del modelo.")

response = client.post(

"/analyze",

json={"text": test_text_with_error}

)

assert response.status_code == status.HTTP_400_BAD_REQUEST

assert response.json()["detail"] == "Error simulado en la inferencia del modelo."

mock_inference.assert_called_once_with(test_text_with_error)

def test_analyze_text_internal_server_error(client):

"""Prueba el manejo de errores genéricos del servidor."""

test_text = "Cualquier texto que no cause un error específico."

with patch("app.main.mock_ai_inference", new_callable=AsyncMock) as mock_inference:

mock_inference.side_effect = Exception("Algo salió muy mal.") # Simula un error inesperado

response = client.post(

"/analyze",

json={"text": test_text}

)

assert response.status_code == status.HTTP_500_INTERNAL_SERVER_ERROR

assert response.json()["detail"] == "Error interno del servidor."

mock_inference.assert_called_once_with(test_text)

def test_analyze_text_environment_variable_model_version(client):

"""Prueba que la versión del modelo se obtiene de la variable de entorno."""

os.environ["AI_MODEL_VERSION"] = "v2.0.0-beta"

test_text = "Texto para probar la versión del modelo."

expected_response_data = {

"sentiment": {"label": "neutral", "score": 0.5},

"keywords": ["texto", "probar", "versión", "modelo"],

"model_version": "v2.0.0-beta"

}

with patch("app.main.mock_ai_inference", new_callable=AsyncMock) as mock_inference:

mock_inference.return_value = expected_response_data

response = client.post(

"/analyze",

json={"text": test_text}

)

assert response.status_code == status.HTTP_200_OK

assert response.json()["model_version"] == "v2.0.0-beta"

del os.environ["AI_MODEL_VERSION"] # Limpiar la variable de entorno después del test

Ejecución de Tests

Para ejecutar los tests, simplemente ve a la raíz de tu proyecto (ia-api-testing/) y ejecuta:

pytest

Deberías ver un informe indicando que todos tus tests pasaron.

Mini Proyecto / Aplicación Sencilla: Análisis de Sentimiento Básico

El código proporcionado en los pasos anteriores ya constituye un mini proyecto funcional. Hemos creado una API FastAPI con un endpoint /analyze que simula el análisis de sentimiento y extracción de palabras clave de un texto. Los tests cubren:

- Casos de éxito con datos válidos.

- Validación de entrada (longitud mínima y máxima del texto).

- Manejo de errores específicos de la inferencia de IA.

- Manejo de errores internos genéricos del servidor.

- Lectura de variables de entorno para configuración.

Este ejemplo demuestra cómo puedes estructurar tu código y tus tests para una aplicación de IA sencilla, asegurando que cada componente funcione correctamente y que la API maneje diversas situaciones de entrada y errores.

Errores Comunes y Depuración

Al escribir tests para APIs de IA, los desarrolladores junior-mid a menudo se encuentran con los siguientes problemas:

- No mockear dependencias externas: Intentar llamar a APIs de IA reales o bases de datos en cada test ralentiza drásticamente la suite de tests y puede generar costos inesperados. Recuerda usar

unittest.mock.patchopytest-mockpara simular estas interacciones. [9, 26] - Tests que dependen del estado global: Si tus tests modifican variables globales o el estado de la aplicación sin limpiarlo después, pueden afectar a otros tests, llevando a resultados inconsistentes. Los fixtures de Pytest con un

scope="function"o"module"ayudan a gestionar esto. [35] - Falta de cobertura de casos límite: Es fácil probar el "camino feliz", pero los errores suelen ocurrir en los bordes. Asegúrate de probar entradas inválidas, valores nulos, cadenas vacías, límites de longitud, y escenarios de error de las dependencias.

- Dificultad para depurar tests fallidos: Cuando un test falla, el mensaje de error de Pytest es muy útil. Utiliza

print()o un depurador (comopdbo el depurador de VS Code) dentro de tus tests para inspeccionar variables y entender el flujo de ejecución. - Ignorar la validación de Pydantic en tests: La validación de Pydantic es una característica clave de FastAPI. Asegúrate de que tus tests incluyan casos donde la entrada no cumpla con los modelos Pydantic y que la API responda con el código de estado 422 esperado. [10, 22]

- No probar el manejo de excepciones: Es vital verificar que tu API maneja correctamente las excepciones, tanto las esperadas (como

HTTPException) como las inesperadas (errores 500). Puedes usarpatch.side_effectpara forzar que una función mockeada lance una excepción. [15, 17]

Aprendizaje Futuro

Una vez que domines los fundamentos del testing con FastAPI y Pytest, puedes explorar áreas más avanzadas:

- Cobertura de Código: Utiliza

pytest-covpara medir qué porcentaje de tu código está cubierto por tests. Esto te ayuda a identificar áreas sin probar y mejorar la calidad general. [5, 11, 16, 21, 23] - Integración Continua (CI/CD): Automatiza la ejecución de tus tests en cada push o pull request utilizando herramientas como GitHub Actions o GitLab CI/CD.

- Testing de Rendimiento: Herramientas como Locust pueden ayudarte a simular cargas de usuarios para probar el rendimiento y la escalabilidad de tu API de IA.

- Testing de Seguridad: Explora herramientas y metodologías para identificar vulnerabilidades de seguridad en tus APIs.

- Testing de Modelos de IA: Más allá de la integración de la API, el testing de modelos se centra en evaluar la calidad y el sesgo de las predicciones del modelo en sí, utilizando métricas específicas de ML.

- Dependency Overrides: FastAPI permite sobrescribir dependencias, lo cual es útil para inyectar mocks o configuraciones específicas para tests (ej. una base de datos de prueba). [8, 12]

El testing es una habilidad esencial que te diferenciará como desarrollador. Invertir tiempo en aprender y aplicar estas prácticas te permitirá construir aplicaciones de IA más robustas, fiables y fáciles de mantener.