Guía Completa para Construir un Sistema de Búsqueda Semántica con LangChain y FAISS en Python

La búsqueda semántica es una técnica avanzada que permite encontrar información relevante no solo por coincidencia literal de palabras, sino interpretando el significado del texto. En esta guía práctica, aprenderemos a construir un sistema de búsqueda semántica usando Python, LangChain como framework para construir cadenas de procesamiento de lenguaje natural, y FAISS, una biblioteca para realizar búsquedas rápidas en bases de datos vectoriales.

Este tutorial está dirigido a desarrolladores con conocimientos intermedios en Python y fundamentos básicos en machine learning, interesados en aplicar tecnologías de última generación para mejorar sistemas de recuperación de información.

¿Qué es la Búsqueda Semántica?

La búsqueda tradicional se basa en palabras clave exactas, pero la búsqueda semántica aprovecha representaciones vectoriales (embeddings) del texto, que capturan su significado. Por ejemplo, "automóvil" y "coche" pueden estar cerca en el espacio vectorial aunque sean palabras distintas.

Esto permite recuperar documentos relevantes sin necesidad de que contengan literalmente el término buscado.

Herramientas Clave: LangChain y FAISS

- LangChain: Un framework en Python que facilita la creación de pipelines y el manejo de modelos de lenguaje, conectando inputs, embeddings, búsquedas y generación de texto.

- FAISS (Facebook AI Similarity Search): Biblioteca altamente optimizada para búsqueda y clustering eficiente en bases de datos grandes de vectores.

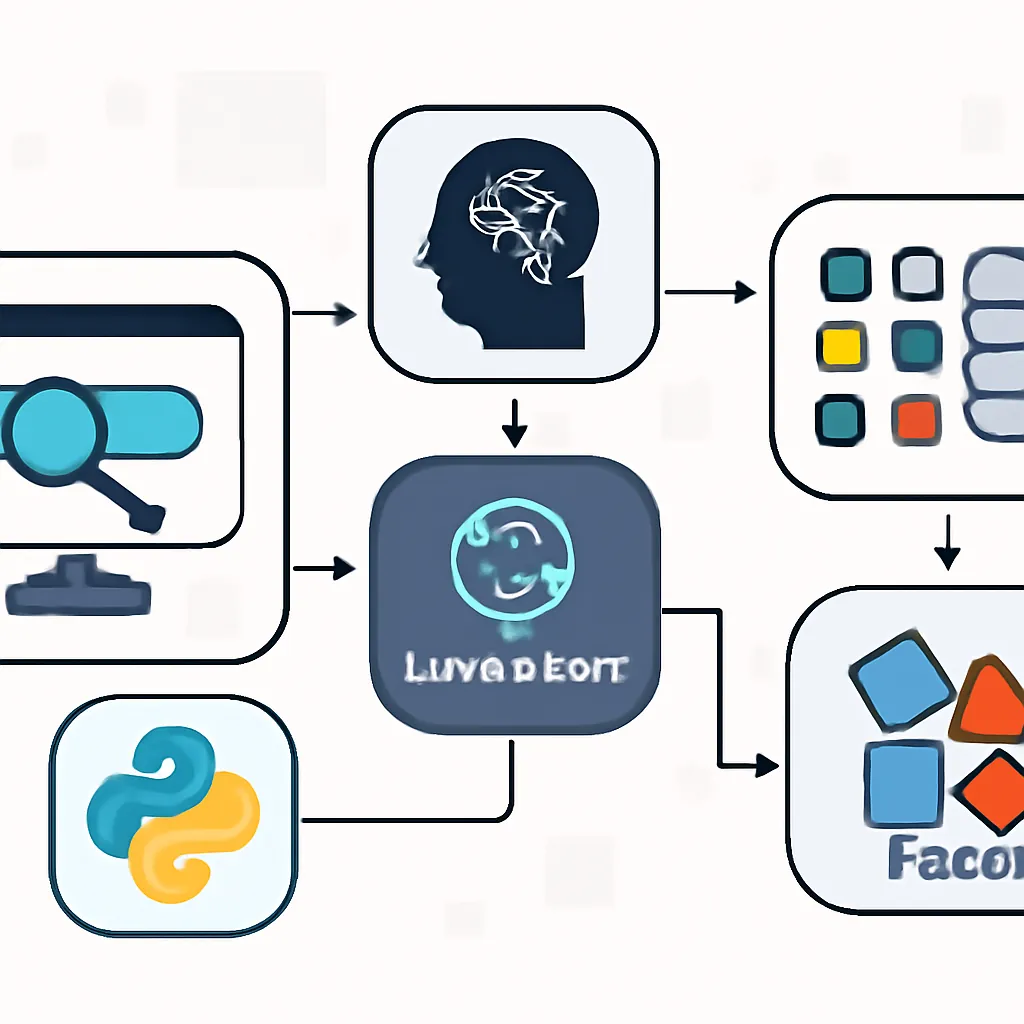

Arquitectura General del Sistema

- Generar embeddings de los documentos o textos a indexar.

- Indexar estos embeddings en FAISS para una recuperación eficiente.

- Al recibir una consulta, generar su embedding y utilizar FAISS para encontrar los documentos más relevantes.

- Opcionalmente, usar LangChain para orquestar el flujo, integración con modelos de lenguaje y mejorar la respuesta.

Preparación del Entorno

Instalaremos las librerías necesarias:

pip install langchain faiss-cpu openaiNecesitarás además una clave API de OpenAI para generar los embeddings (o cualquier otro proveedor compatible).

Ejemplo Práctico en Python

A continuación, construimos un sistema básico que indexa unos textos y permite realizar consultas semánticas.

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS

from langchain.chains import RetrievalQA

from langchain.llms import OpenAI

# Textos a indexar

documentos = [

"El clima hoy es soleado con temperaturas agradables.",

"Python es un lenguaje de programación muy popular para IA.",

"La IA está transformando la industria tecnológica rápidamente.",

"Los vehículos eléctricos son el futuro de la movilidad sostenible.",

"OpenAI desarrolla modelos de lenguaje avanzados como GPT.",

]

# Inicializamos embeddings usando OpenAI

embeddings = OpenAIEmbeddings()

# Creamos la base de vectores con FAISS

vectorstore = FAISS.from_texts(documentos, embeddings)

# Configuramos la cadena de preguntas y respuestas con recuperación

llm = OpenAI(temperature=0)

qa = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff",

retriever=vectorstore.as_retriever()

)

# Consulta de ejemplo

query = "¿Qué lenguaje se usa para programación en IA?"

respuesta = qa.run(query)

print("Consulta:", query)

print("Respuesta:", respuesta)

Este código realiza lo siguiente:

- Define un conjunto de documentos para indexar.

- Genera embeddings con OpenAI y crea un índice FAISS sobre ellos.

- Configura un pipeline LangChain para responder preguntas usando esos documentos semánticamente.

- Consulta y obtiene una respuesta basada en la información almacenada.

Consideraciones para Producción

- Escalabilidad: Para bases de datos muy grandes, FAISS soporta índices en disco y búsquedas aproximadas (IVF, HNSW).

- Tipos de Embeddings: Se pueden usar modelos locales o de otros proveedores para evitar dependencias externas y costos asociados.

- Actualización del índice: Añadir documentos o reindexar puede hacerse incrementalmente o por lotes.

- Optimización: Ajustar parámetros de FAISS y LangChain para mejorar la latencia y precisión de la búsqueda.

Conclusión

Construir un sistema de búsqueda semántica utilizando LangChain y FAISS es accesible y poderoso para mejorar la recuperación de información en aplicaciones modernas. Este enfoque permite superar las limitaciones de la búsqueda de texto literal y ofrecer resultados mucho más relevantes y contextuales.

Con Python y estas herramientas, es posible montar prototipos rápidos y escalables, que combinan lo mejor de la representación semántica y el procesamiento de lenguaje natural.